《Spark与Hadoop大数据分析》——3.1 启动 Spark 守护进程

如果你计划使用 Standalone 的集群管理器,则需要启动 Spark 的主机(master)和工作机(worker)的守护进程(daemon),它们是 Spark 架构的核心组件。守护进程的启动/停止在不同的发行版里略有差异。Hadoop 发行版(如 Cloudera、Hortonworks 和 MapR)会把 Spark 作为服务,并把 YARN 作为默认的资源管理器。这意味着在默认情况下所有 Spark 应用程序都会在 YARN 框架上运行。但是,要使用 Spark 的 Standalone 资源管理器,我们就需要启动 Spark 的主机和工作机角色。如果你计划使用 YARN 资源管理器,就不需要启动这些守护进程。请根据你使用的发行版类型,按照以下步骤进行操作。所有这些发行版的下载和安装说明可以参阅第 2 章中的内容。

3.1.1 使用CDHCloudera的Hadoop发行版(Cloudera Distribution for Hadoop,CDH)是一个开源的发行版,其中包括Hadoop、Spark 和大数据分析所需的许多其他项目。Cloudera Manager 是用来安装和管理CDH平台的。如果你计划使用YARN资源管理器,请在Cloudera Manager中启动Spark服务。要为 Spark 的Standalone 资源管理器启动 Spark 守护进程,请采用以下过程:

(1)CDH 平台上的 Spark 是配置成和 YARN一起使用的。此外,Spark 2.0目前在 CDH上还不可用。所以,要下载最新的预制版 Spark 2.0 Hadoop包,请按照第2章中所解释的步骤进行。如果你想使用 Spark 1.6 版本,请运行 /usr/lib/spark/start-all.sh命令。

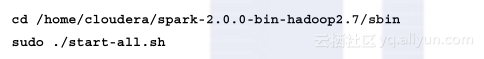

(2)请使用以下命令启动服务。

(3)在 http://quickstart.cloudera:8080/ 可以查看 Spark 的用户界面。

3.1.2 使用 HDP、MapR 和 Spark 预制软件包Hortonworks数据平台(Hortonworks Data Platform,HDP)和 MapR 融合数据平台(MapR Converged Data Platform)的发行版中也包括Hadoop、Spark 和大数据分析所需的许多其他项目。HDP 使用 Apache Ambari 部署和管理集群,而 MapR 使用MapR控制系统(MapR Control System,MCS)。Spark 的预制包里没有用于管理 Spark 的特定管理器组件。如果你计划使用 YARN 资源管理器,请在 Ambari 或 MCS 中启动 Spark 服务。要启动 Spark 守护程序以便使用 Spark 的 Standalone 资源管理器,请采用以下过程。

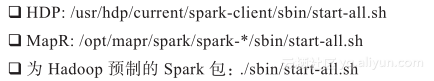

(1)用以下命令启动服务:

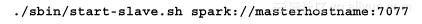

对于多节点集群,请用以下命令在所有计算机上启动 Spark 的工作机角色:

另一种选项是在 /conf/slaves 文件中提供工作机的主机名称列表,然后使用 ./start-all.sh 命令自动在所有计算机上启动工作机角色。

(2)请检查位于logs目录中的日志。可以在 http://masterhostname:8080 上查看主机的Web界面。如果此端口已由另一个服务占用,则会使用下一个可用端口。例如,在 HDP 中,端口 8080 由 Ambari 获取,因此Standalone的主机将绑定到 8081。要查找正确的端口号,请检查日志。

Apache Spark中国社群 有奖投稿通道 启动啦! 感谢对 Apache Spark 中国社区的关注和支持!如果您有意为 Apache Spark 中国社区投稿请关注如下的内容。 投稿内容要求: 内容要求是 Apache Spark 相关的技术内容,可以是对 Apache Spark 的分析,也可以是 Apache Spark 的实践。

相关文章

- 编写Java代码打印Hadoop中DataNode中的数据

- 大数据-Hadoop-YARN:资源调度器【YARN负责为运算程序提供服务器运算资源,相当于一个分布式的操作系统平台,而MapReduce等运算程序则相当于运行于操作系统之上的应用程序】

- Spark:超越Hadoop MapReduce

- 为什么说Storm比Hadoop快?

- hadoop 伪分布式集群的搭建

- 《Spark与Hadoop大数据分析》——1.5 小结

- Hadoop技术让大数据处理变得简单

- 大数据入门第五天——离线计算之hadoop(下)hadoop-shell与HDFS的JavaAPI入门

- Hadoop & Spark & Hive & HBase

- 【Hadoop】HA 场景下访问 HDFS JAVA API Client

- Hadoop On Demand配置指南

- hadoop学习要点

- 大数据面试题百日更新_Hadoop专题(Day06)

- Hadoop-2.6.0NodeManager Restart Recover实现分析(二)