spark 1.X standalone和on yarn安装配置

2023-09-14 09:00:23 时间

安装JDK 1.7以上 Hadoop 2.7.0不支持JDK1.6,Spark 1.5.0开始不支持JDK 1.6

安装Scala 2.10.4

安装 Hadoop 2.x 至少HDFS

spark-env.sh

export JAVA_HOME= export SCALA_HOME= export HADOOP_CONF_DIR=/opt/modules/hadoop-2.2.0/etc/hadoop //运行在yarn上必须要指定 export SPARK_MASTER_IP=server1 export SPARK_MASTER_PORT=8888 export SPARK_MASTER_WEBUI_PORT=8080 export SPARK_WORKER_CORES= export SPARK_WORKER_INSTANCES=1 export SPARK_WORKER_MEMORY=26g export SPARK_WORKER_PORT=7078 export SPARK_WORKER_WEBUI_PORT=8081 export SPARK_JAVA_OPTS="-verbose:gc -XX:-PrintGCDetails -XX:PrintGCTimeStamps"

slaves指定worker节点

xx.xx.xx.2 xx.xx.xx.3 xx.xx.xx.4 xx.xx.xx.5

运行spark-submit时默认的属性从spark-defaults.conf文件读取

spark-defaults.conf

spark.master=spark://hadoop-spark.dargon.org:7077

启动集群

start-master.sh start-salves.sh

spark-shell命令其实也是执行spark-submit命令

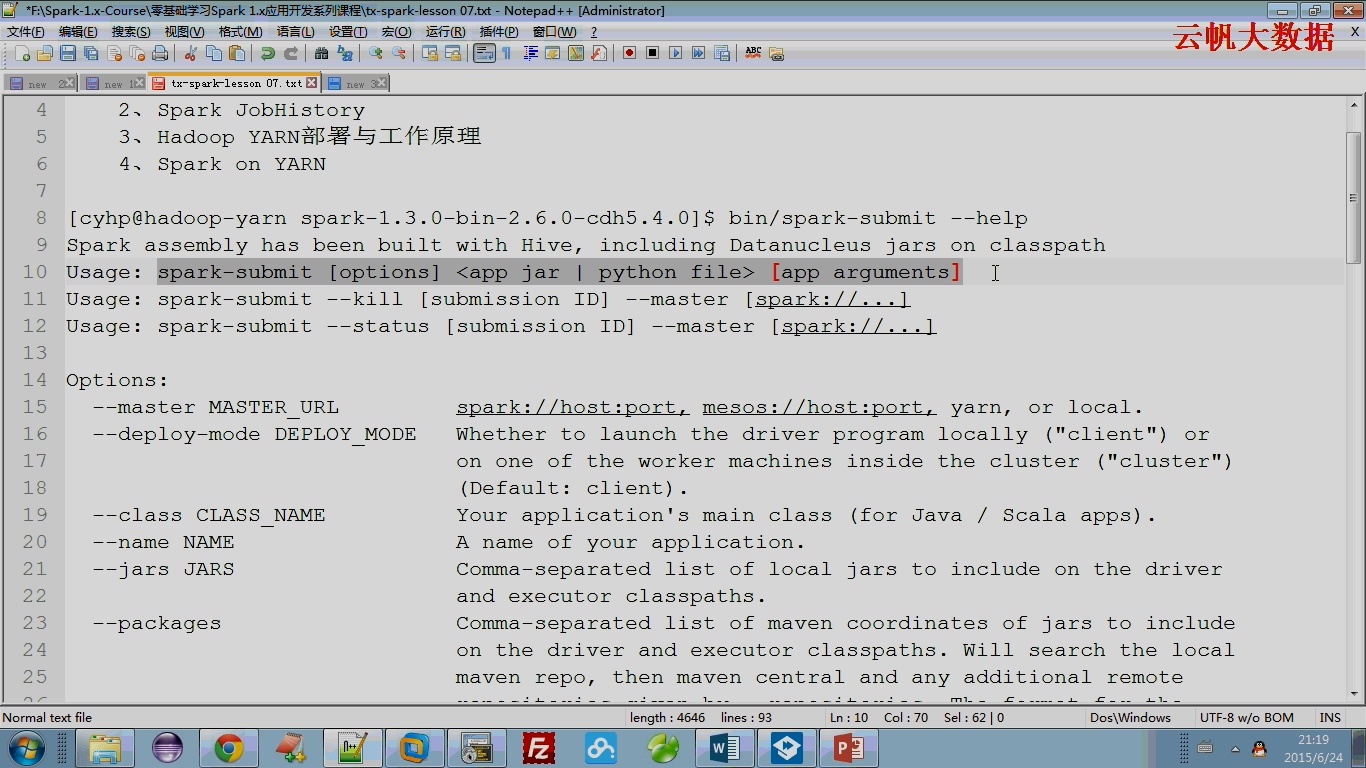

spark-submit --help

deploy-mode针对driver program(SparkContext)的client(本地)、cluster(集群)

默认是client的,SparkContext运行在本地,如果改成cluster则SparkContext运行在集群上

hadoop on yarn的部署模式就是cluster,SparkContext运行在Application Master

spark-shell quick-start链接

http://spark.apache.org/docs/latest/quick-start.html

本文出自 “点滴积累” 博客,请务必保留此出处http://tianxingzhe.blog.51cto.com/3390077/1711959

在idea里面怎么远程提交spark任务到yarn集群 很久没有更新了,因为最近一段时间有点小忙,最近也是有同学问我说自己在idea里面写spark程序测试,每次都要打包然后上传到集群,然后spark-submit提交很麻烦,可不可以在idea里面直接远程提交到yarn集群呢? 当然是可以的,今天就给大家分享一下具体的操作过程. 那先来说一下spark任务运行的几种模式: 1,本地模式,在idea里面写完代码直接运行.

spark on yarn模式安装和配置carbondata 前置条件 Hadoop HDFS 和 Yarn 需要安装和运行。 Spark 需要在所有的集群节点上安装并且运行。 CarbonData 用户需要有权限访问 HDFS. 以下步骤仅针对于 Driver 程序所在的节点. (Driver 节点就是启动 SparkContext 的节点)

11月14日Spark社区直播【 Spark on Kubernetes & YARN】 本次直播将讨论:以Kubernetes为代表的云原生技术越来越流行起来,spark是如何跑在Kubernetes之上来享受云原生技术的红利?Spark跑在Kubernetes之上和跑在Hadoop YARN上又有什么区别?以及Kubernetes 和YARN的差异点是什么。

基于Yarn API的Spark程序监控 一.简述 通过对Yarn ResourceManager中运行程序的状态(RUNNING、KILLED、FAILED、FINISHED)以及ApplicationMaster中Application的Job执行时长超过批次时间的监控,来达到对Spark on Yarn程序的失败重启、超时重启等功能

Hadoop大数据平台实战(05):深入Spark Cluster集群模式YARN vs Mesos vs Standalone vs K8s Hadoop大数据平台实战(05):Spark Cluster集群模式YARN, Mesos,Standalone和K8s深入对比。监控,调度,监控,安全机制,特性对比,哪个才是最好的Spark集群管理工具。

大数据分布式架构单点故障详解(Hdfs+Yarn+HBase+Spark+Storm)构建HA高可用架构 本文梳理了常见的hadoop生态圈中的组件:Hdfs+Yarn+HBase+Spark+Storm的单点故障问题,出现原因以及单点故障的原理和解决方案(构建HA(High Available)高可用架构)。阅读本文之前,最好了解清楚各组件的架构原理。

相关文章

- Android Studio 提示 Unable to access Android SDK add-on list 问题处理

- gitlab 15.8 on rocky 8

- vue中$refs、$emit、$on的使用场景

- ORA-28602: statement not permitted on tables containing bitmap indexes ORACLE 报错 故障修复 远程处理

- ORA-38726: Flashback database logging is not on. ORACLE 报错 故障修复 远程处理

- MySQL Error number: 3912; Symbol: ER_GROUPING_ON_TIMESTAMP_IN_DST; SQLSTATE: HY000 报错 故障修复 远程处理

- ORA-03113: end-of-file on communication channel ORACLE 报错 故障修复 远程处理

- ORA-12024: materialized view log on “string”.”string” does not have primary key columns ORACLE 报错 故障修复 远程处理

- linux中安装eclipse,安装好之后不能直接建servlet,不能直接在jsp页面中run on server.权限在作怪,我猜的,详解编程语言

- [email protected]_on条件编译详解编程语言

- 安装Vue on Linux:轻松搭建开发环境(linux安装vue)

- 一步步安装MySQL服务器on Linux操作系统(mysqllinux安装)

- 如何在CentOS 8上安装Ruby on Rails

- 对 “Ubuntu on Windows” 的一种解读

- 渗透测试工具Mimikatz ON Metasploit

- Enjoying a Streamlined Linux Experience on VHD(vhdlinux)

- Installing QQ on Linux: A Guide to Getting Started(linux下安装qq)

- Guide to installing Linux on iPad – Stepbystep instructions for tech enthusiasts(ipad安装linux)

- Exploring the Benefits and Compatibility of JDK1.6 on Linux OS(jdk1.6linux)

- Maximizing Audio Performance: Exploring AMP Technology on Linux Systems(amplinux)

- Oracle内连接ON极大提高数据查询性能(oracle内连接on)

- delete cascadeOracle 中 ON DELETE CASCADE 的使用(oracle中的on)

- 使用Oracle On关键字实现数据库连接(oracle on关键字)