【三维目标检测】Complex-Yolov4详解(一): 数据处理

本文为博主原创文章,未经博主允许不得转载。

本文为专栏《python三维点云从基础到深度学习》系列文章,地址为“https://blog.csdn.net/suiyingy/article/details/124017716”。

前面分别介绍了基于点云的三维深度学习算法PointNet、PointNet++,和基于体素的三维深度学习算法VoxelNet。本节将开始介绍基于投影的三维深度学习算法Complex-Yolov4。三维投影算法主要思想是用激光雷达点云的鸟瞰图(BEV)和前视图(FV)作为模型输入,将三维点云转换为二维图片,早期工作开始于2017年的MV3D。

激光雷达点云的鸟瞰图和前视图的详细介绍请参考:点云鸟瞰图BEV原理与可视化_Coding的叶子的博客-CSDN博客和详细理解雷达点云前视图(FV, Front View)_Coding的叶子的博客-CSDN博客。

算法参考来源于Github上的Complex Yolov4,地址为:https://github.com/maudzung/Complex-YOLOv4-Pytorch。

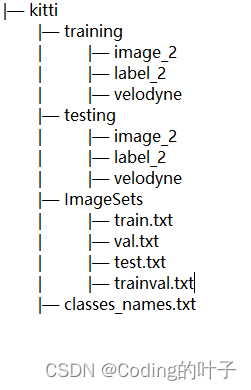

1 数据目录结构

Complex-Yolov4的数据来源于KITTI数据集,其目录结构如下图所示。为了快速进行算法调试、训练、评估和验证,以及快速下载,我制作了一个mini kitti数据集,数据集的文件目录结构与完整KITTI数据集保持一致。其中,小型的KITTI数据集,即 mini kitti保存了20个训练样本和5个测试样本。下载地址为:minikitti数据集-深度学习文档类资源-CSDN下载,详细介绍请参考:KITTI数据集简介 — Mini KITTI_Coding的叶子的博客-CSDN博客https://blog.csdn.net/suiyingy/article/details/124820161。下载的数据包含4个部分,即激光雷达数据velodyne、图像数据image_2、校准数据calib和标注数据label_2。

除了Mini Kitti数据之外还需ImageSets和classes_names.txt。ImageSets文件夹中定义了训练、验证和测试样本的全部名称。ImageSets可以参考Complex-Yolov4自带的内容进行定义,需要与Mini Kitti保持一致,也可以直接下载,下载地址为:train_val_testforminikitti-深度学习文档类资源-CSDN下载。下载后将文件夹重名为ImageSets即可。

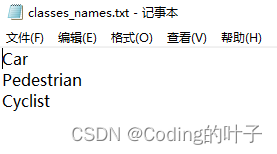

classes_names.txt存储了需要检测的目标类别,其默认内容如下图所示:

2 数据处理

(1)读取激光雷达数据Nx4、标签数据和校准数据。

(2)从标签中筛选出关注的标签,如Car,每个标签label长度为8,分别是x、y、z、h、w、l、ry,其中x、y、z和ry是相机坐标系中的取值。利用校准数据Calib,相机坐标系下的x、y、z和ry转换为雷达坐标系下的x、y、z和rz,具体原理和过程可以参考KITTI数据集简介(四) — 标定校准数据calib_Coding的叶子的博客-CSDN博客和三维点云目标检测 — VoxelNet详解之数据处理 (二)_Coding的叶子的博客-CSDN博客两篇博客。注意到,VoxelNet代码和Complex-Yolo代码中关于坐标从相机坐标系变换到雷达坐标系的代码是不同的,VoxelNet参考代码中少了R0_rect的逆矩阵。将补充后的代码如下所示:

def camera_to_lidar(x, y, z, V2C=None, R0=None, P2=None):

p = np.array([x, y, z, 1])

if V2C is None or R0 is None:

p = np.matmul(cnf.R0_inv, p)

p = np.matmul(cnf.Tr_velo_to_cam_inv, p)

else:

R0_i = np.zeros((4, 4))

R0_i[:3, :3] = R0

R0_i[3, 3] = 1

p = np.matmul(np.linalg.inv(R0_i), p)

p = np.matmul(inverse_rigid_trans(V2C), p)

p = p[0:3]

return tuple(p)(3)将标注参数投影到图像中,获得投影后的x、y、w、l,详细介绍同Voxelnet部分:三维点云目标检测 — VoxelNet详解之数据处理 (二)_Coding的叶子的博客-CSDN博客。

(4)将x、y、w、l、rz转换成yolo格式,其中rz用欧拉公式转换为虚部(im)和实部(re)。这样最终真实标签target由8个维度组成,即batch_id、class_id、x、y、w、l、im、re。

(5)删除指定范围之外的激光雷达数据:kitti_bev_utils.removePoints(lidarData, cnf.boundary)。

(6)获取鸟瞰图(BEV)rgb_map:由强度图intensityMap(608x608)、高度图heightMap(608x608)和密度图densityMap(608x608)共同组成3x608x608维度的鸟瞰图,类似于3通道的RGB图片。这也是该算法核心思想的体现。鸟瞰图详细介绍请参考:点云鸟瞰图BEV原理与可视化_Coding的叶子的博客-CSDN博客。本程序中xoy平面内的网格尺寸由Discretization参数决定,取值为(boundary["maxX"] - boundary["minX"]) / BEV_HEIGHT

(7)读取到的数据需要经过随机水平翻转或Cutout增强。

经过上述7个步骤,可以得到模型输出的数据包含img_file、rgb_map、targets。假设Batch Size大小为B。img_file存储了image_2中对应图片的路径列表,长度为B。Rgb_map为步骤(6)中的鸟瞰图,维度为Bx3X608x608。targets为真实标签,根据(4)中定义可以知道其维度为Mx8,M为目标总数量。

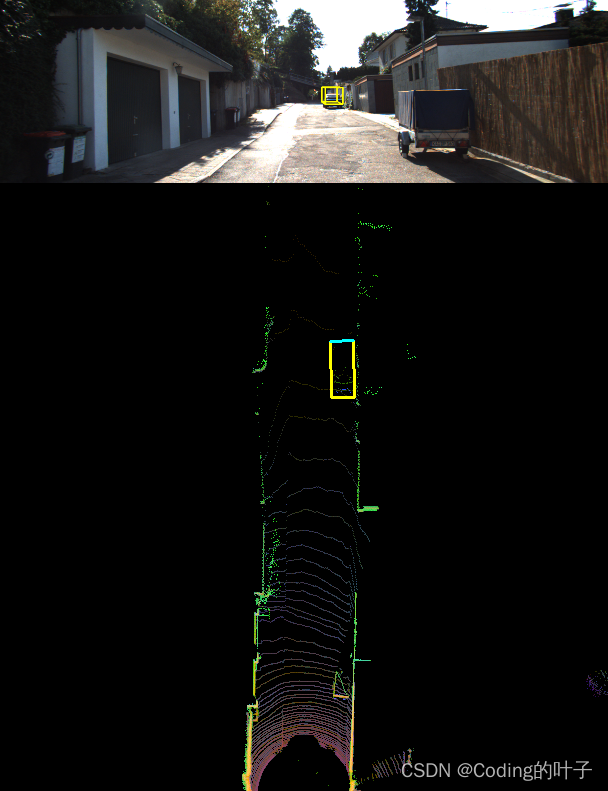

3 数据可视化

运行src/data_process目录下的kitti_dataloader.py文件,可以得到部分可视化结果,如下图所示。

4 python三维点云从基础到深度学习_Coding的叶子的博客-CSDN博客_python三维点云重建

更多三维、二维感知算法和金融量化分析算法请关注“乐乐感知学堂”微信公众号,并将持续进行更新。

本文为博主原创文章,未经博主允许不得转载。

本文为专栏《python三维点云从基础到深度学习》系列文章,地址为“https://blog.csdn.net/suiyingy/article/details/124017716”。

相关文章

- python执行脚本加参数_命令行运行Python脚本时传入参数的三种方式详解以及argparse子命令subparsers()方法

- PyCharm中Debug模式进行调试详解

- python mysql-connector模块连接数据库详解

- WordCount代码实现详解

- CSDN日报190909:详解Github周冠军项目Faceswap的变脸攻略

- zookeeper的ZAB协议的原理以及底层源码实现超级详解

- QT中QThread的各个方法,UI线程关系,事件关系详解(4)

- 《Android游戏开发详解》——第1章,第1.2节数据类型

- 《Android游戏开发详解》——第2章,第2.12节设置和访问对象的状态

- ArrayAdapter详解:ArrayAdapter(Context context, int textViewResourceId, T[] objects)

- 【蓝桥杯】【2019省赛】【填空题】最大降雨量(详解)(简单解法)

- Android Action Bar 详解篇 .

- git switch 命令详解

- 无人机巡检场景小目标检测与量化加速部署方案详解

- atof()函数详解

- iOS 中的 HotFix 方案总结详解

- 【Unity3D-UGUI系列】(九)Scrollbar 滚动条组件详解

- OkHttp3源码详解(五) okhttp连接池复用机制

- linux cat 命令详解--转

- 【GD32】从0开始学GD32单片机(3)—— GPIO外设详解+点亮LED和按钮检测例程

- UML类图与类的关系详解