阿里云MVP Meetup 《云数据·大计算:海量日志数据分析与应用》之《数据采集:日志数据上传》篇

2023-09-27 14:26:07 时间

大数据workshop:《云数据·大计算:海量日志数据分析与应用》之《数据采集:日志数据上传》篇

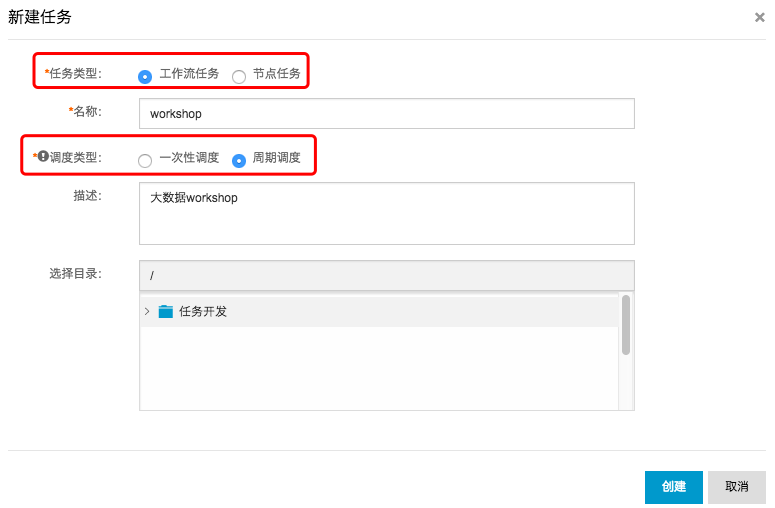

step2:选择工作流任务,调度类型选择为周期调度,其他配置项如下。

step2:选择工作流任务,调度类型选择为周期调度,其他配置项如下。

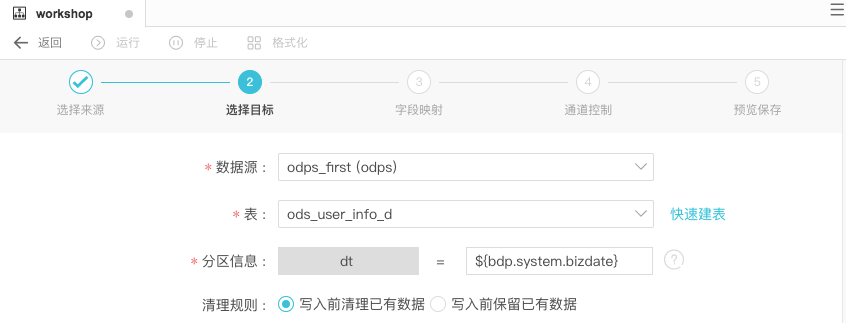

step2:选择目标。点击下一步。 step4:在下一步操作中配置通道控制,作业速率上限为10MB/s,进入下一步。

step4:在下一步操作中配置通道控制,作业速率上限为10MB/s,进入下一步。

免费下载!阿里云MVP携《DevOps权威指南:IT效能“新基建”》重磅登场 本书由阿里云开发者社区联合阿里云MVP、人民邮电出版社共同推出 DevOps 已在互联网、金融和制造等领域落地实践。本书主要内容包括 DevOps 的基本概念,DevOps 的工具集,支撑管理,敏捷开发,持续集成和测试,持续部署和持续交付,代码质量和安全,DevOps 的 度量体系,持续改进和反馈,DevOps 最佳实践,以及 DevOps 的后续发展。 本书适合企业级 DevOps 项目中不同角色、不同参与模式下的用户阅读,也适合作为大专院校和相关 培训机构的教学用书。

乘云而上的阿里云MVP--第16期全球发布 阿里云最有价值专家,简称阿里云 MVP(Most Valuable Professional),是专注于帮助他人充分了解和使用阿里云的技术实践领袖。 第16期阿里云MVP正式全球发布,本期共有12位来自顶尖高等教育教学领域的专家加入阿里云MVP大家庭,也是首批高校阿里云MVP认证计划。

乘风破浪的阿里云MVP--第13期全球发布 阿里云最有价值专家,简称阿里云 MVP(Most Valuable Professional),是专注于帮助他人充分了解和使用阿里云的技术实践领袖。第13期阿里云MVP于今日正式全球发布,本期共有31位来自世界的顶尖技术型专家加入阿里云MVP大家庭

擅长顺势而为,收获家业两成——对话阿里云 MVP杨飞 云栖号资讯:【点击查看更多行业资讯】在这里您可以找到不同行业的第一手的上云资讯,还在等什么,快来! 简介: 对比大多数开发者来说,杨飞的职业路线可以说是大相径庭。从大厂到创业公司,从一线城市回归二线……对于事业和生活,他的选择一直很独特。

本手册为阿里云MVP Meetup Workshop《云计算·大数据:海量日志数据分析与应用》的《数据采集:日志数据上传》篇而准备。主要为保障各位学员在workshop当天能够顺畅进行动手实操,那么本节为学员掌握阿里云数据采集的操作和使用。

实验涉及大数据产品 大数据计算服务 MaxCompute 大数据开发套件 Data IDE项目名需要字母或下划线开头,只能包含字母下划线和数字。

【注意】项目名称全局唯一,建议大家采用自己容易区分的名称来作为本次workshop的项目空间名称。

确保阿里云账号处于登录状态。

step1:点击进入大数据开发套件项目列表。

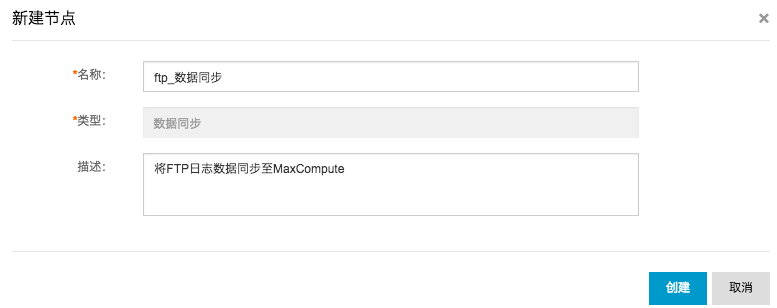

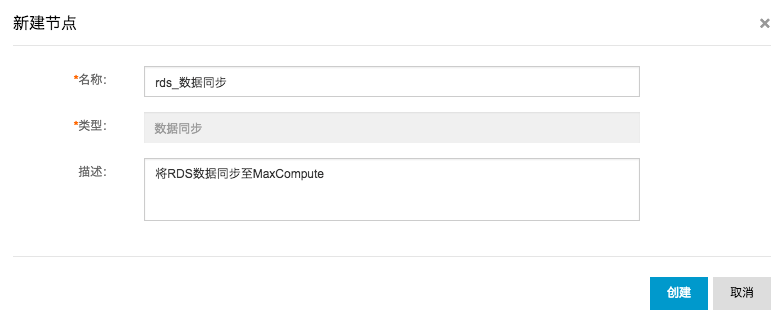

根据workshop模拟的场景,需要分别创建FTP数据源和RDS数据源。

1.新建FTP数据源 step1:点击数据集成 数据源管理,继而点击新增数据源。

FTP数据源配置信息如下:

数据源类型类型:有公网ip 数据源名称:ftp_workshop_log 数据源描述:ftp日志文件同步 Protocol:sftp Host:10.80.177.33 Port:22 用户名/密码:workshop/workshop step3:点击测试连通性,连通性测试通过后,点击确定保存配置。

RDS数据源配置信息如下:

数据源类型:阿里云数据库(RDS) 数据源名称:rds_workshop_log 数据源描述:rds日志数据同步 RDS实例名称:rm-bp1z69dodhh85z9qa RDS实例购买者ID:1156529087455811 数据库名:workshop 用户名/密码:workshop/workshop#2017 step3:点击测试连通性,连通性测试通过后,点击确定保存配置。

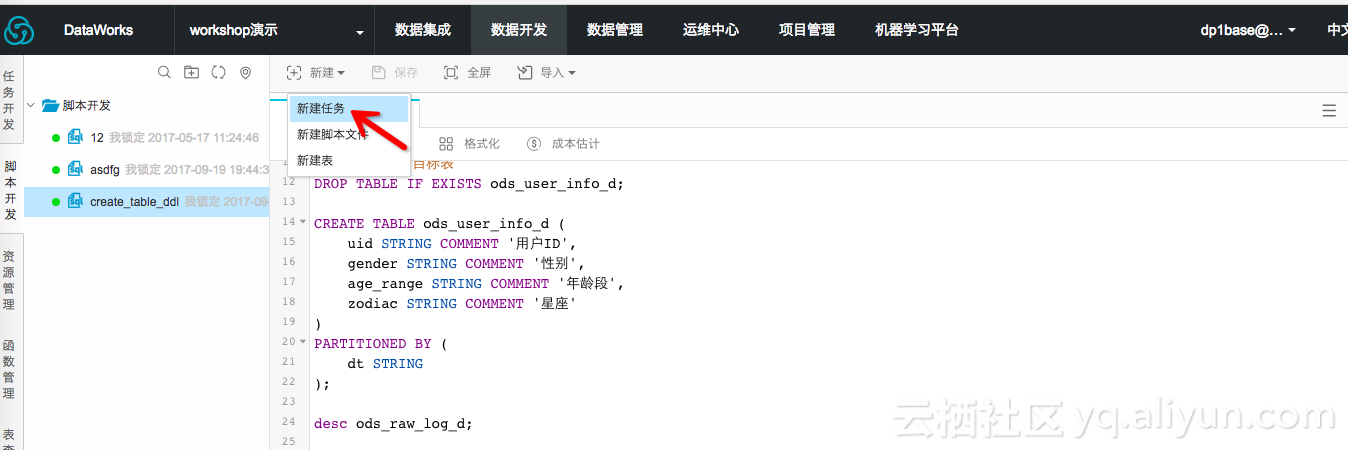

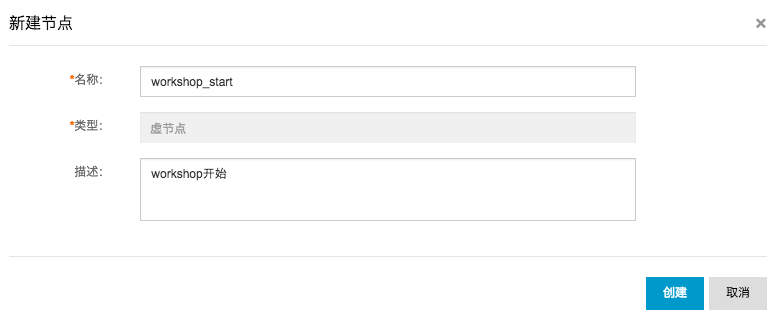

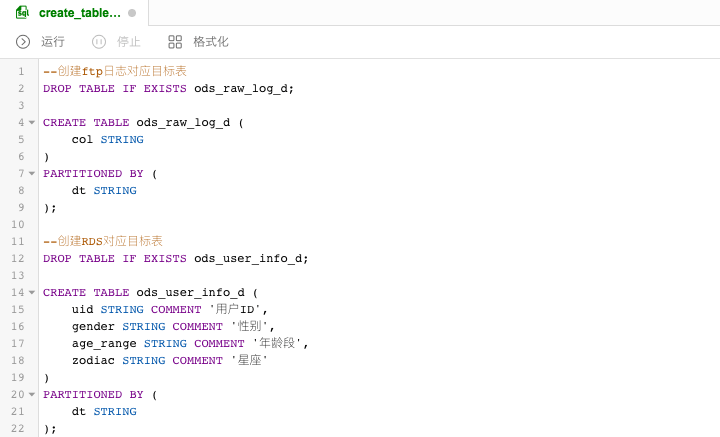

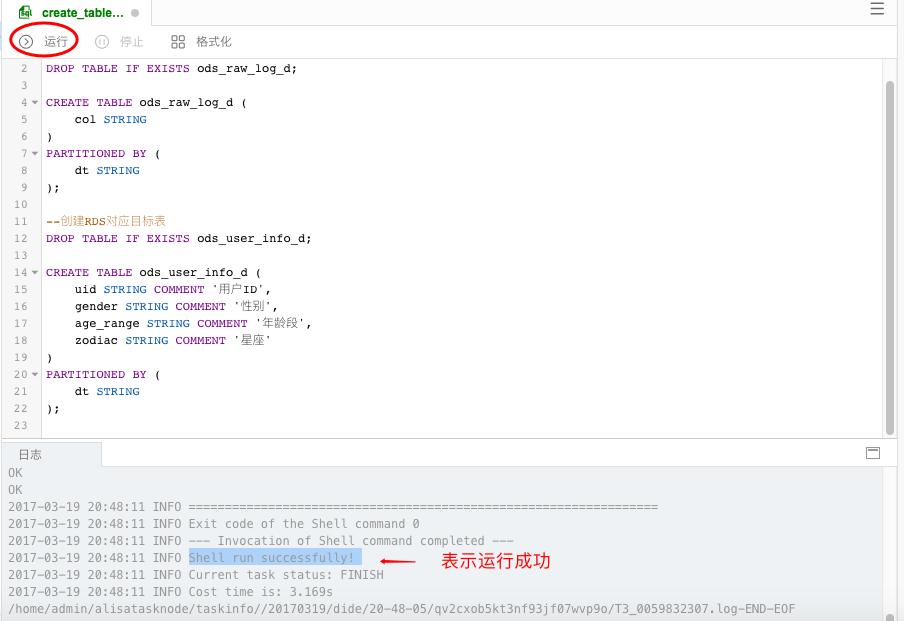

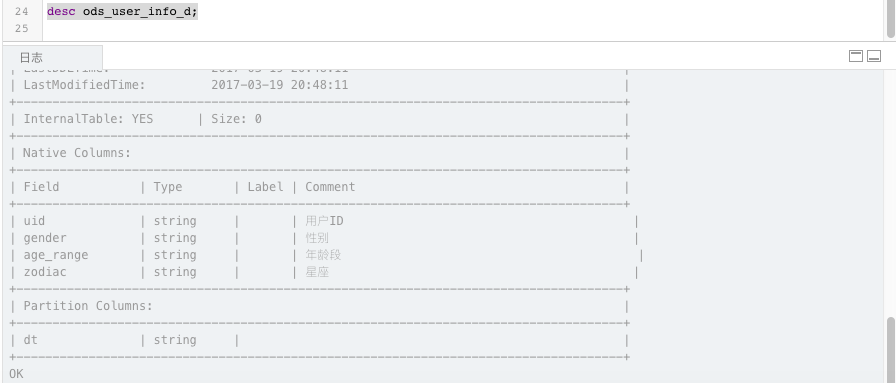

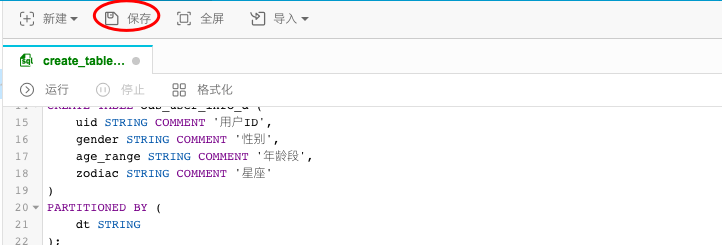

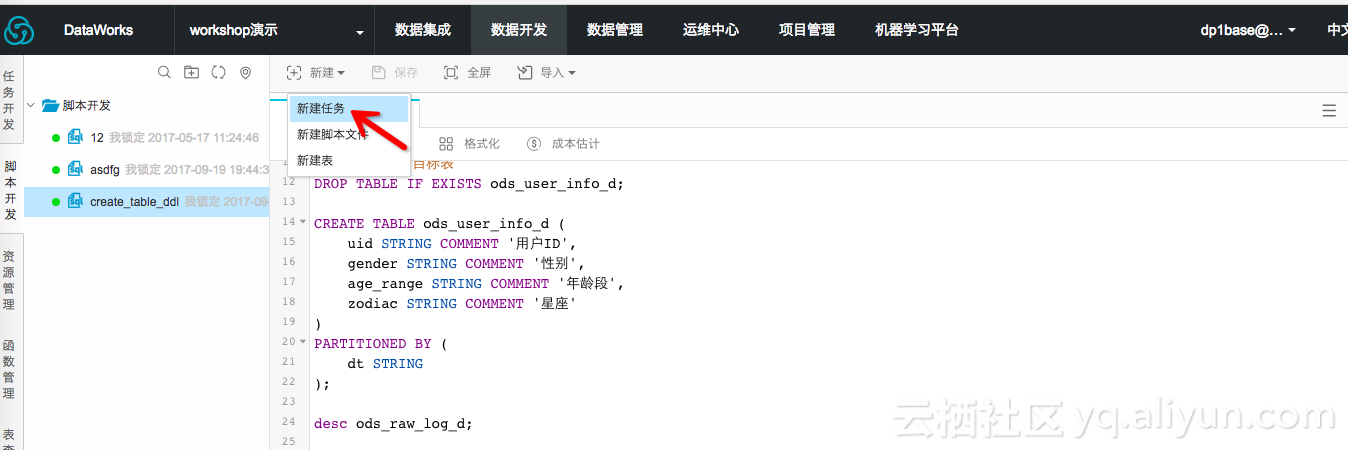

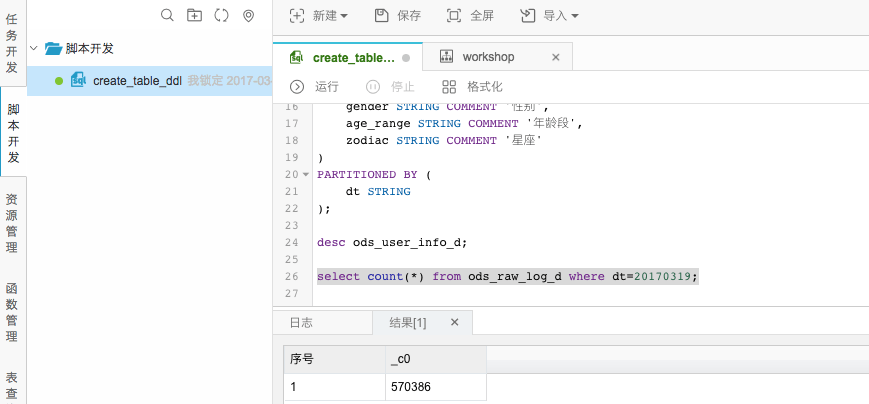

DDL语句如下:

--创建ftp日志对应目标表 DROP TABLE IF EXISTS ods_raw_log_d; CREATE TABLE ods_raw_log_d ( col STRING PARTITIONED BY ( dt STRING --创建RDS对应目标表 DROP TABLE IF EXISTS ods_user_info_d; CREATE TABLE ods_user_info_d ( uid STRING COMMENT 用户ID, gender STRING COMMENT 性别, age_range STRING COMMENT 年龄段, zodiac STRING COMMENT 星座 PARTITIONED BY ( dt STRING );step3:点击运行,直至日志信息返回成功表示两张目标表创建成功。

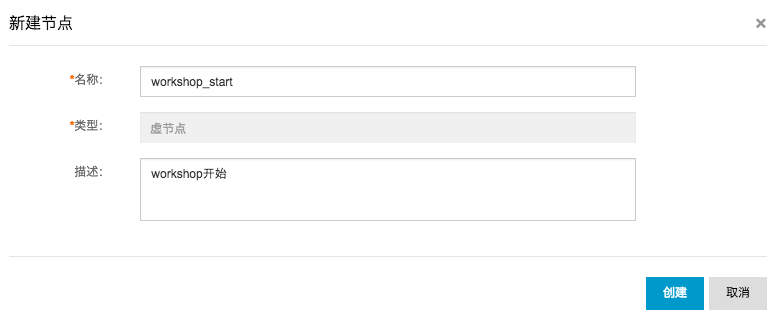

step2:选择工作流任务,调度类型选择为周期调度,其他配置项如下。

step2:选择工作流任务,调度类型选择为周期调度,其他配置项如下。

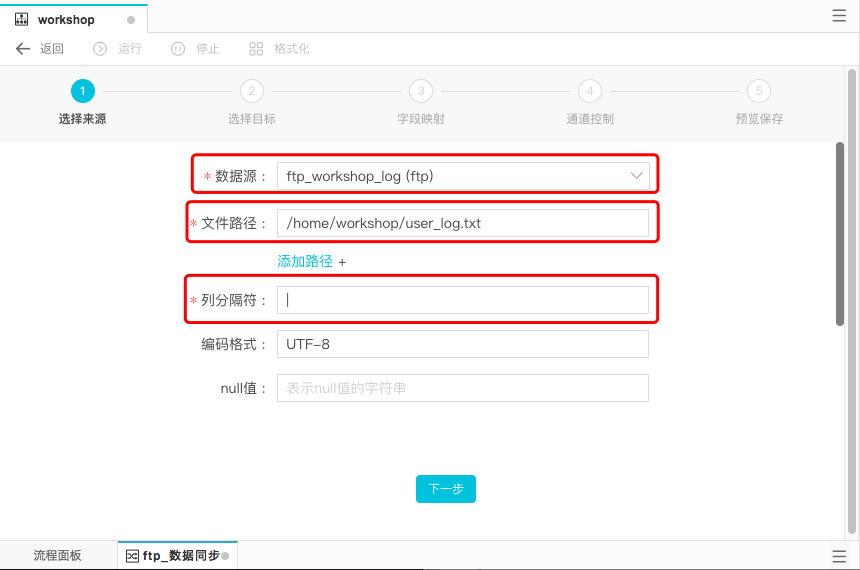

数据来源配置项具体说明如下:

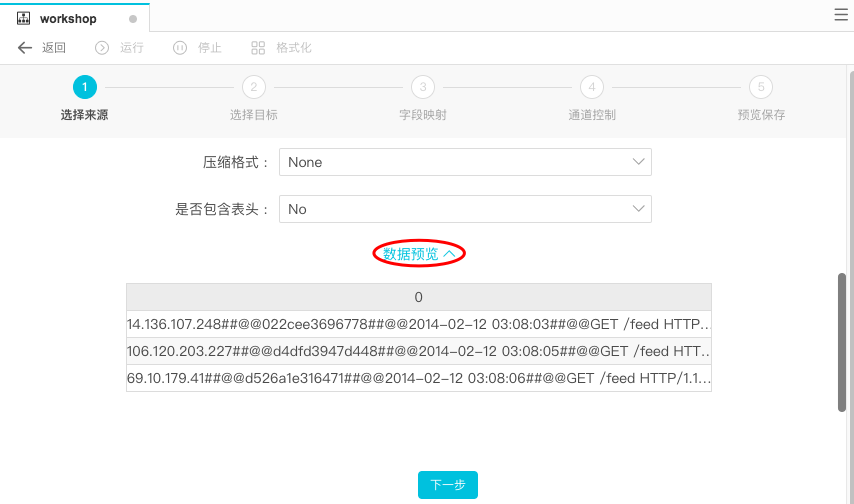

数据来源:ftp_workshop_ftp 文件路径:/home/workshop/user_log.txt 列分隔符:|step2:选择目标。点击下一步。

数据流向选择数据源为odps_first,表名为ods_raw_log_d。分区信息和清理规则都采取系统默认,即清理规则为写入前清理已有数据,分区按照${bdp.system.bizdate}。

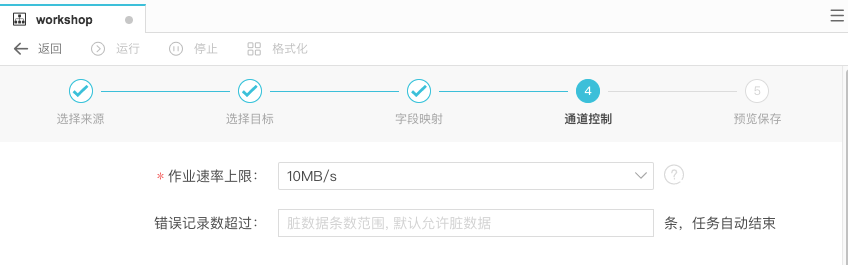

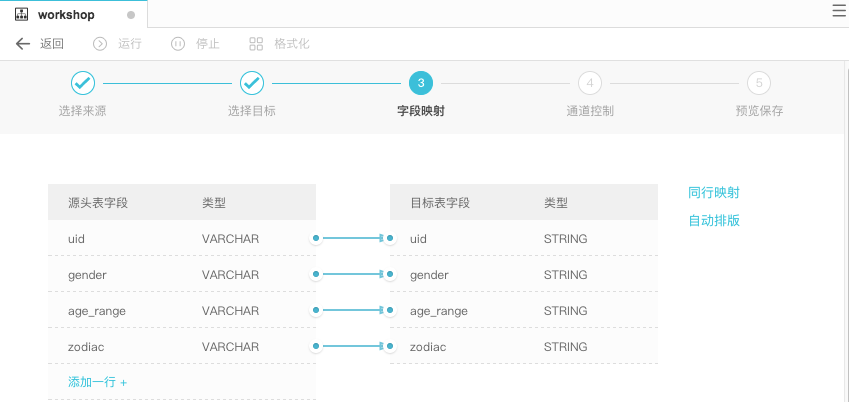

step3:配置字段映射。连接要同步的字段。如下: step4:在下一步操作中配置通道控制,作业速率上限为10MB/s,进入下一步。

step4:在下一步操作中配置通道控制,作业速率上限为10MB/s,进入下一步。

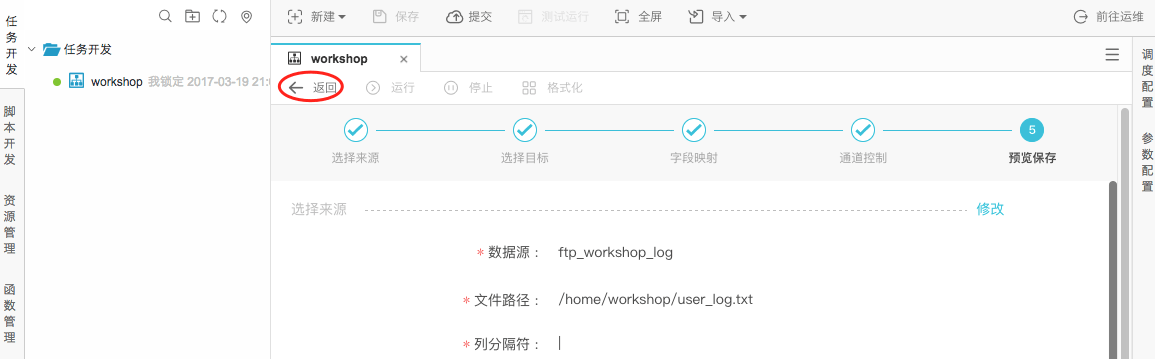

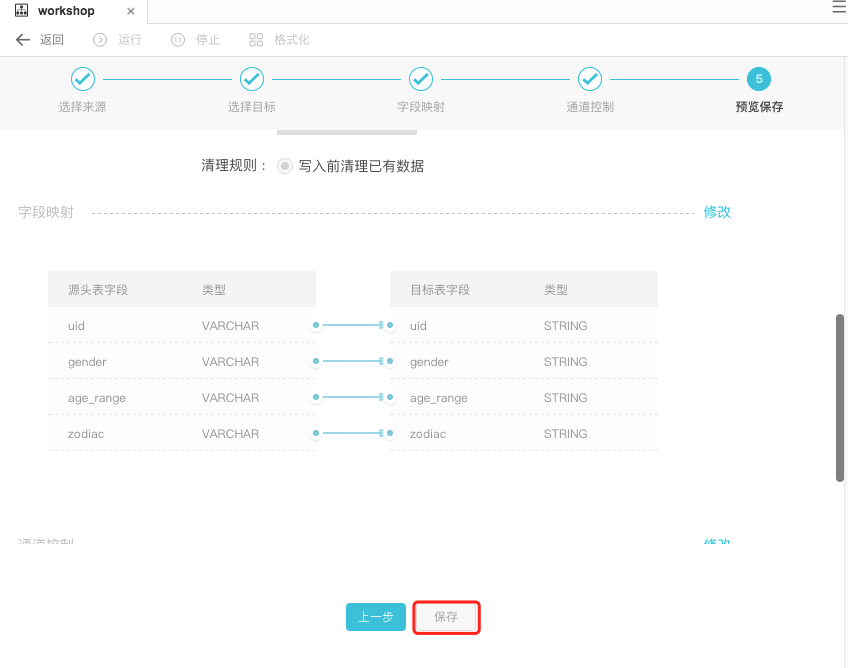

可在预览保存页面中,预览上述的配置情况,也可以进行修改,确认无误后,点击保存。

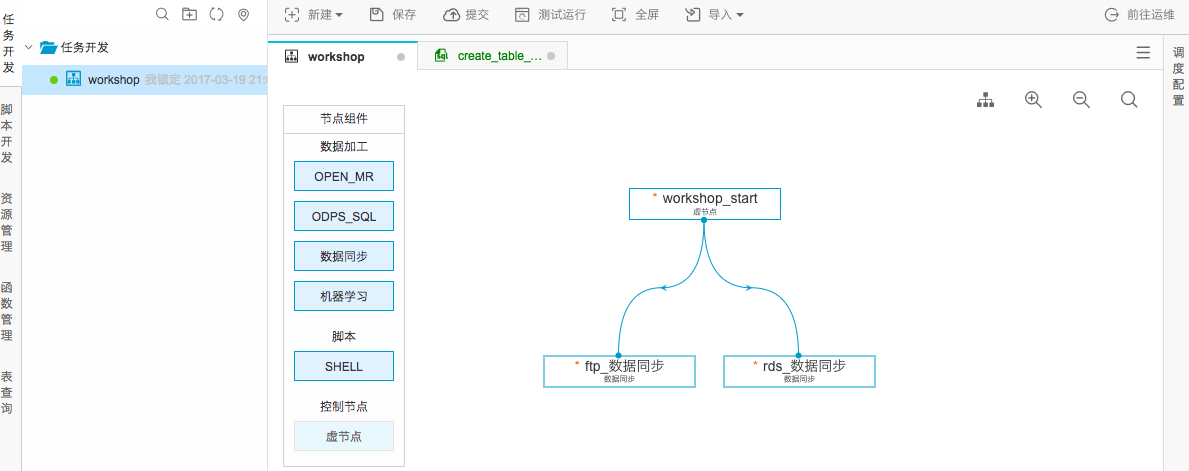

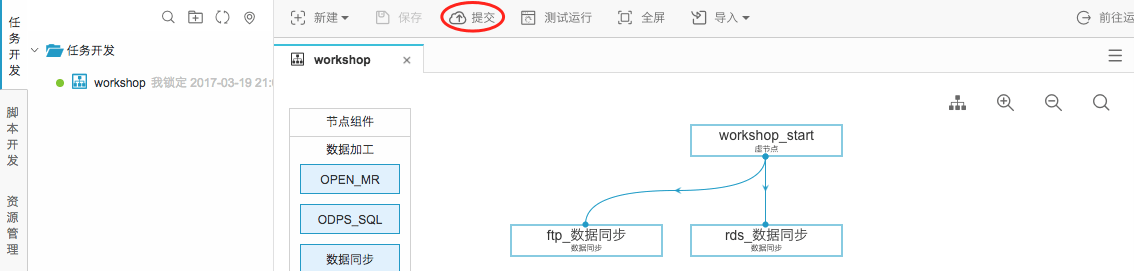

step5:点击返回工作流面板。

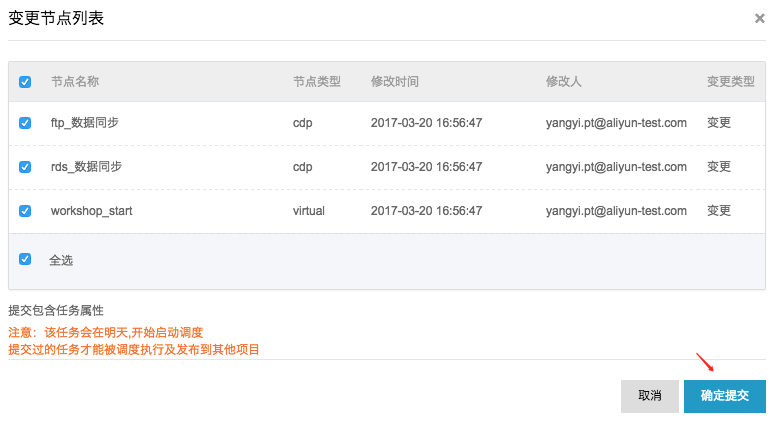

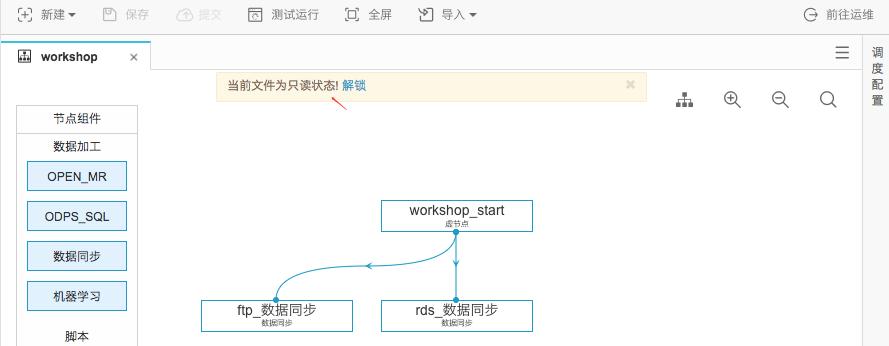

提交成功后工作流任务处于只读状态,如下:

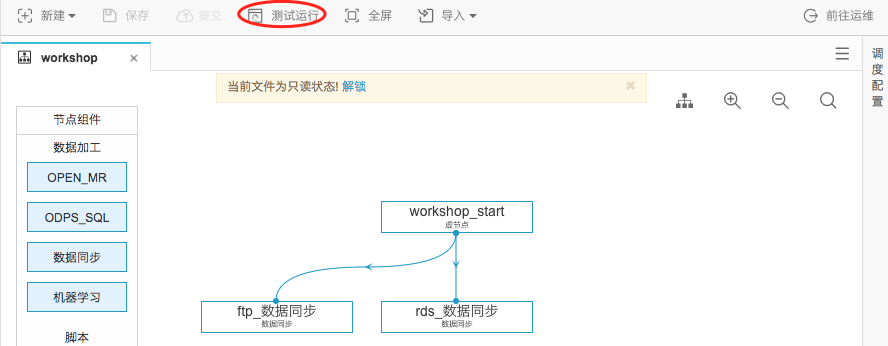

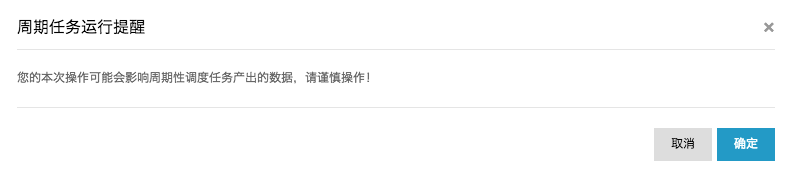

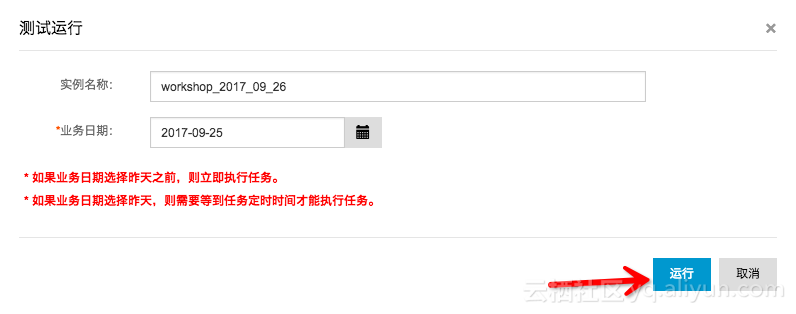

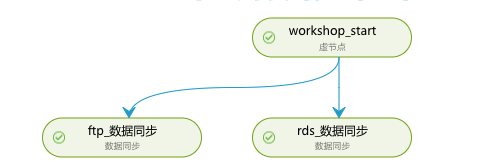

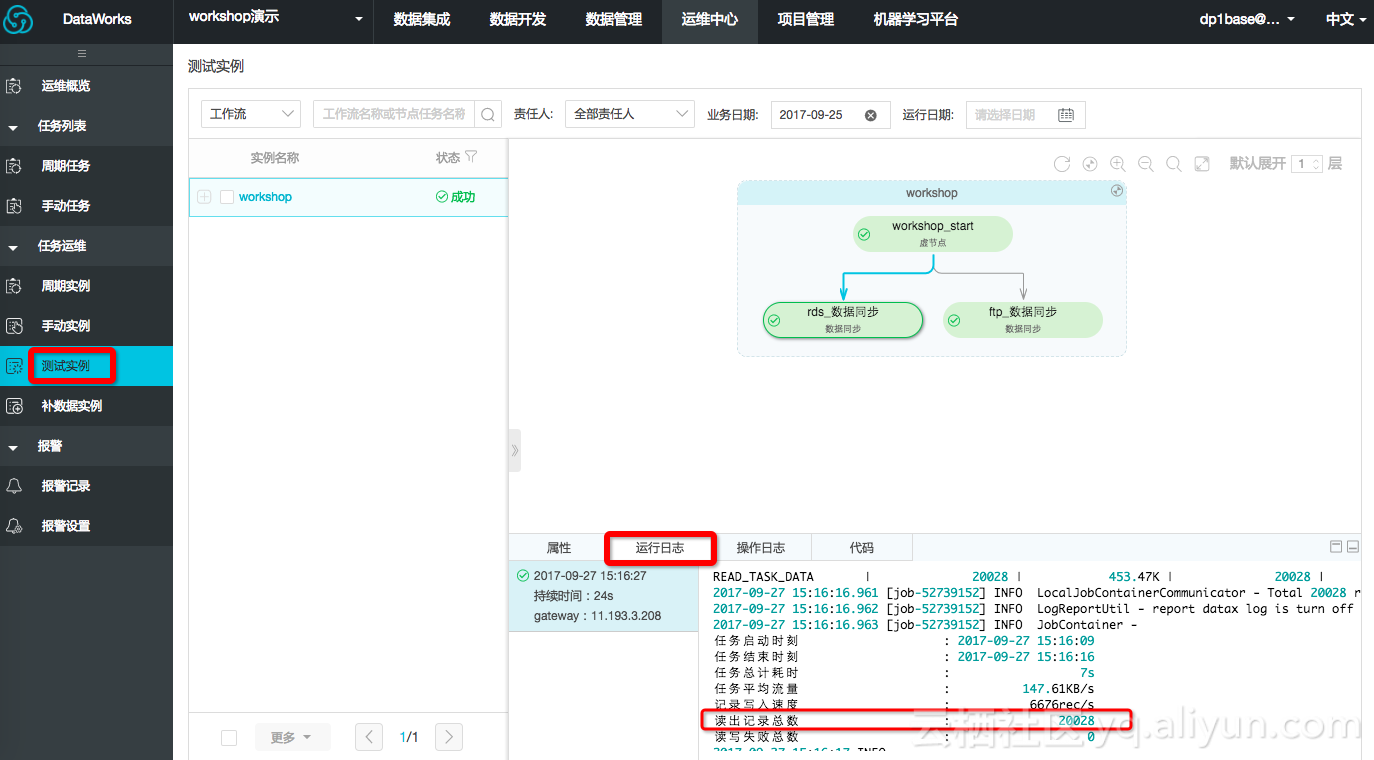

在运维中心可以查看任务视图,如下图表示该工作流任务(名称为workshop_start)正在运行。

直至所有节点都运行返回成功状态即可(需要点击运维视窗中的刷新按钮查看实时状态)。如下所示:

)

附录:SQL语句如下,其中分区键需要更新为业务日期,如测试运行任务的日期为20171011,那么业务日期为20171010.

---查看是否成功写入MaxCompute select count(*) from ods_raw_log_d where dt=业务日期; select count(*) from ods_user_info_d where dt=业务日期;

免费下载!阿里云MVP携《DevOps权威指南:IT效能“新基建”》重磅登场 本书由阿里云开发者社区联合阿里云MVP、人民邮电出版社共同推出 DevOps 已在互联网、金融和制造等领域落地实践。本书主要内容包括 DevOps 的基本概念,DevOps 的工具集,支撑管理,敏捷开发,持续集成和测试,持续部署和持续交付,代码质量和安全,DevOps 的 度量体系,持续改进和反馈,DevOps 最佳实践,以及 DevOps 的后续发展。 本书适合企业级 DevOps 项目中不同角色、不同参与模式下的用户阅读,也适合作为大专院校和相关 培训机构的教学用书。

乘云而上的阿里云MVP--第16期全球发布 阿里云最有价值专家,简称阿里云 MVP(Most Valuable Professional),是专注于帮助他人充分了解和使用阿里云的技术实践领袖。 第16期阿里云MVP正式全球发布,本期共有12位来自顶尖高等教育教学领域的专家加入阿里云MVP大家庭,也是首批高校阿里云MVP认证计划。

乘风破浪的阿里云MVP--第13期全球发布 阿里云最有价值专家,简称阿里云 MVP(Most Valuable Professional),是专注于帮助他人充分了解和使用阿里云的技术实践领袖。第13期阿里云MVP于今日正式全球发布,本期共有31位来自世界的顶尖技术型专家加入阿里云MVP大家庭

擅长顺势而为,收获家业两成——对话阿里云 MVP杨飞 云栖号资讯:【点击查看更多行业资讯】在这里您可以找到不同行业的第一手的上云资讯,还在等什么,快来! 简介: 对比大多数开发者来说,杨飞的职业路线可以说是大相径庭。从大厂到创业公司,从一线城市回归二线……对于事业和生活,他的选择一直很独特。

相关文章

- Confluence 7 手动上传编辑过的文件

- Confluence 6 上传文件

- 图片上传压缩处理

- SecureCRT上传、下载文件 使用rz【上传】& sz【下载】命令

- 124.(前端)上传商品图片——使用elementui中的Upload上传图片

- 使用ajax提交form表单,包括ajax文件上传

- 【甄选靶场】Vulnhub百个项目渗透——项目二十三:mrRobot-1(文件上传,暴力破解,nmap提权)

- 如何调整 php 应用的上传附件大小?

- ASP.NET Core(C#) 存储上传的文件接口及实现方法

- Spring Boot上传文件(multipart和json)到服务器DTO方法及示例代码

- 【错误记录】Google Play 上架报错 ( 上传 release 版本 APK 或 AAB )