基于Apache doris怎么构建数据中台(二)-数据中台建设内容

2023-09-27 14:25:57 时间

这次主要是将基于Doris的数据中台建设内容及系统架构设计

围绕着上次将的我们要解决的五个问题 找数 理解数据 问题评估 取数及数据可视化 给出一个概要的设计及框架

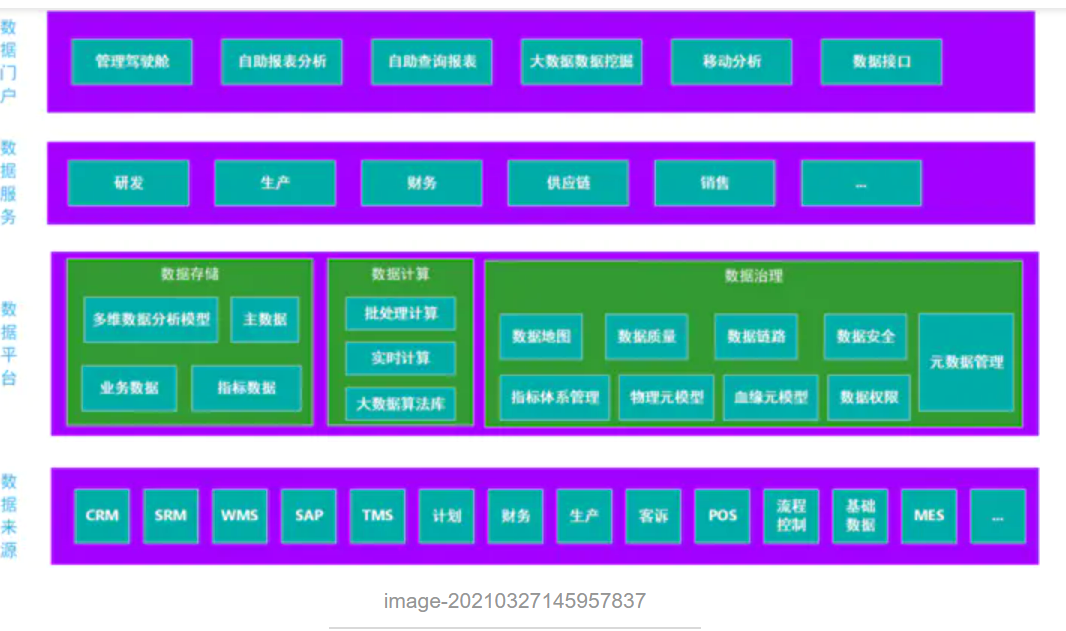

数据中台建设内容

image-20210327145957837

对用户来说 Doris 的优点是功能强大 易用性好。 功能强大指可以满足我们用户的需求 易用性好主要指 兼容 Mysql 协议和语法 以及 Online Schema Change。 兼容 Mysql 协议和语法让用户的学习成本和开发成本很低 Online Schema Change 也是一个很吸引人的 feature 因为在业务快速发展和频繁迭代的情况下 Schema 变更会是一个高频的操作。

对平台侧来说 Doris 的优点是易运维 易扩展和高可用

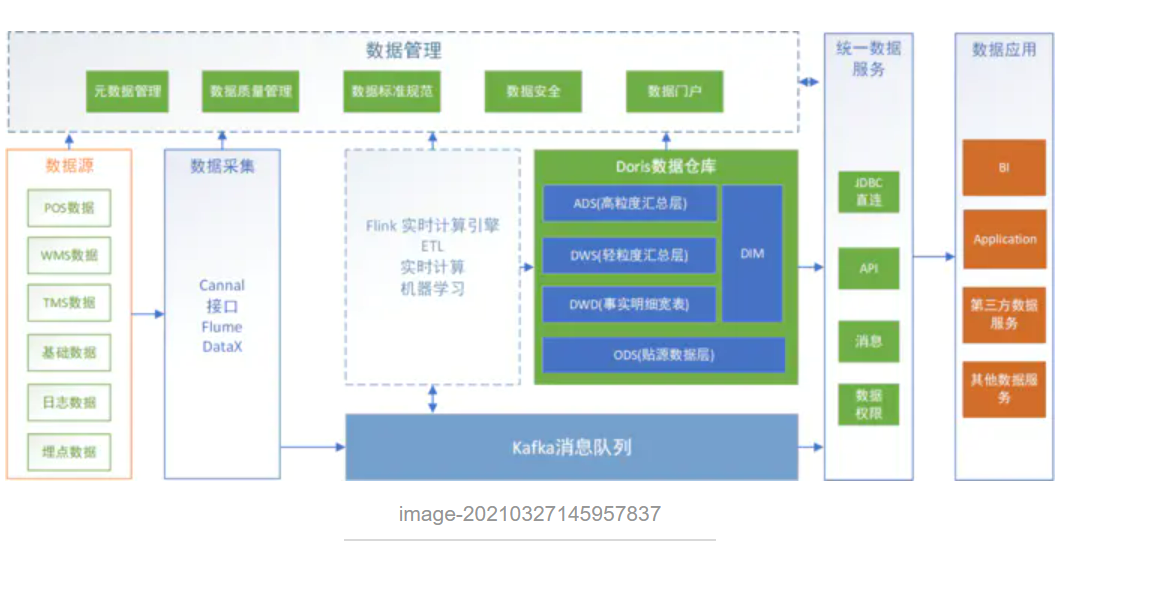

所以这里数仓是使用Doris作为核心组件来构建

image-20210327145957837

架构说明

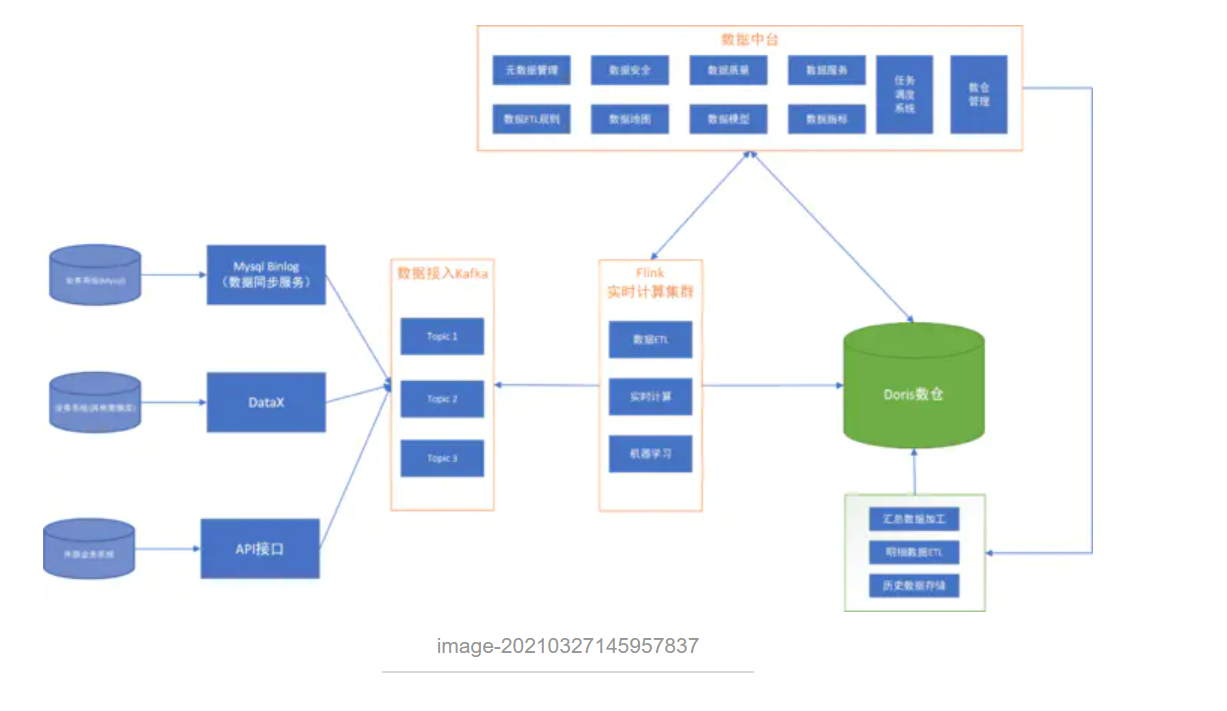

image-20210327145957837

数据中台功能整体规划

这是我们数据中台的整体功能规划 我会在后续展开每个功能

image-20210327145957837

Apache Doris 整合 FLINK CDC + Iceberg 构建实时湖仓一体的联邦查询 这篇教程将展示如何使用 Flink CDC + Iceberg + Doris 构建实时湖仓一体的联邦查询分析,Doris 1.1版本提供了Iceberg的支持,本文主要展示Doris和Iceberg怎么使用,同时本教程整个环境是都基于伪分布式环境搭建,大家按照步骤可以一步步完成。完整体验整个搭建操作的过程。

基于Apache doris怎么构建数据中台(六)-数据服务管理 上次讲数据质量的控制,那么针对据仓的数据及各种数据指标怎么快捷的对外提供数据服务,怎么快速的完成数据服务接口的开发,这次我们重点围绕这个进行展开。怎么实现接口开发零代码实现

基于Apache doris怎么构建数据中台(四)-数据接入系统 在开发数据模型时,我们必须有一个统一的平台,能够像流水线一样,把数据一步步加工成数据模型。这其中涉及到数据萃取、数据聚合、作业调度等。

基于 Apache Hudi 构建增量和无限回放事件流的 OLAP 平台 我们将讨论在构建流数据平台时如何利用 Hudi 的两个最令人难以置信的能力。 增量消费--每 30 分钟处理一次数据,并在我们的组织内构建每小时级别的OLAP平台 事件流的无限回放--利用 Hudi 的提交时间线在超级便宜的云对象存储(如 AWS S3)中存储 10 天的事件流(想象一个具有 10 天保留期的 kafka 主题) 具有部分记录更新的自定义 Hudi Payload 类

相关文章

- 基于Apache Spark机器学习的客户流失预测

- CentOS 8 Apache 启用 SSL

- Flink 学习 — Apache Flink 入门介绍

- 基于Apache doris怎么构建数据中台(六)-数据服务管理

- 3 分钟学会调用 Apache Spark MLlib KMeans

- apache、nginx开启rewrite重写服务及伪静态

- 已解决org.mybatis.spring.MyBatisSystemException: nested exception is org.apache.ibatis.reflection

- 使用Apache Hudi + Amazon S3 + Amazon EMR + AWS DMS构建数据湖

- 如何使用 Apache 设置反向代理

- apache加载模块的说明