深度学习笔记------Faster_RCNN

目录

3 RPN (Region Proposal Networks)

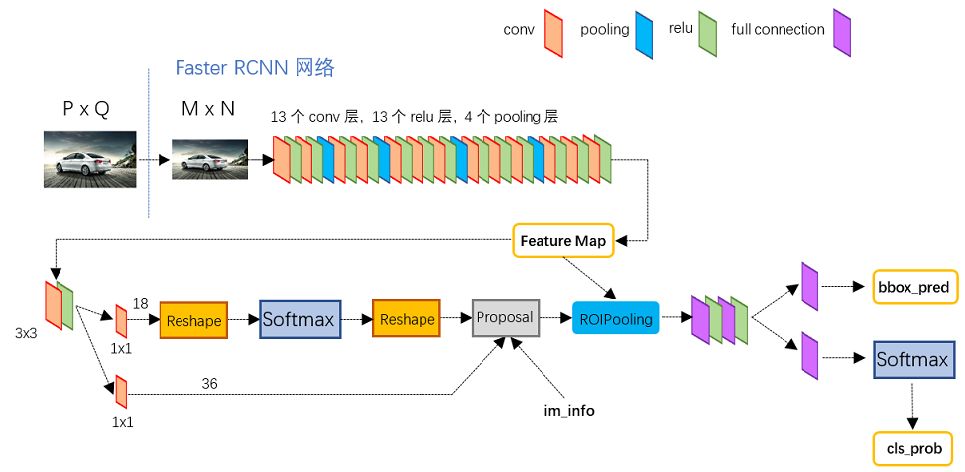

1 Faster_rcnn网络结构

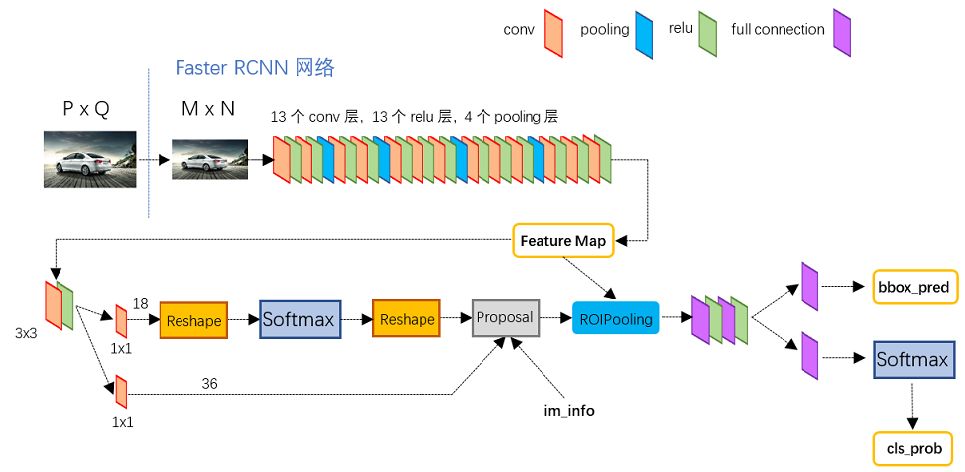

Faster RCNN是两阶段的目标检测算法,包括阶段一的Region proposal以及阶段二的bounding box回归和分类。用一张图来直观展示Faster RCNN的整个流程:

- Conv layers。作为一种CNN网络目标检测方法,Faster RCNN首先使用一组基础的conv+relu+pooling层提取image的feature maps。该feature maps被共享用于后续RPN层和全连接层。

- Region Proposal Networks。RPN网络用于生成region proposals。该层通过softmax判断anchors属于positive或者negative,再利用bounding box regression修正anchors获得精确的proposals。

- Roi Pooling。该层收集输入的feature maps和proposals,综合这些信息后提取proposal feature maps,送入后续全连接层判定目标类别。

- Classification。利用proposal feature maps计算proposal的类别,同时再次bounding box regression获得检测框最终的精确位置。

上图可以清晰的看到该网络对于一副任意大小PxQ的图像:

- 首先缩放至固定大小MxN,然后将MxN图像送入网络;

- 而Conv layers中包含了13个conv层+13个relu层+4个pooling层;

- RPN网络首先经过3x3卷积,再分别生成positive anchors和对应bounding box regression偏移量,然后计算出proposals;

- 而Roi Pooling层则利用proposals从feature maps中提取proposal feature送入后续全连接和softmax网络作classification(即分类proposal到底是什么object)。

2 Faster_RCNN的输入

Faster RCNN首先是支持输入任意大小的图片的,比如上图中输入的P*Q,进入网络之前对图片进行了规整化尺度的设定,如可设定图像短边不超过600,图像长边不超过1000,我们可以假定M*N=1000*600(如果图片少于该尺寸,可以边缘补0,即图像会有黑色边缘)。

经过Conv layers,和池化层的作用。图片大小变成(M/16)*(N/16),即:60*40(1000/16≈60,600/16≈40);则,Feature Map就是60*40*512-d(注:VGG16是512-d,ZF是256-d),表示特征图的大小为60*40,数量为512

3 RPN (Region Proposal Networks)

经典的检测方法生成检测框都非常耗时,如OpenCV adaboost使用滑动窗口+图像金字塔生成检测框;或如R-CNN使用SS(Selective Search)方法生成检测框。而Faster RCNN则抛弃了传统的滑动窗口和SS方法,直接使用RPN生成检测框,这也是Faster R-CNN的巨大优势,能极大提升检测框的生成速度。

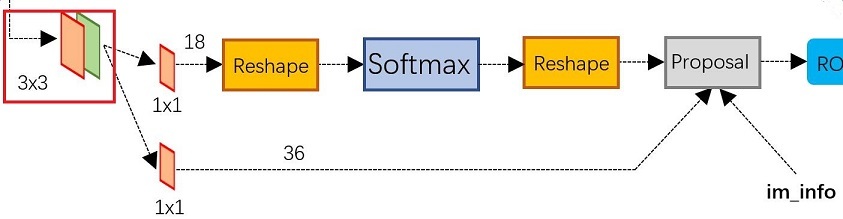

图 RPN网络结构

上图展示了RPN网络的具体结构。Feature Map进入RPN后,先经过一次3*3的卷积,同样,特征图大小依然是60*40,数量512,这样做的目的应该是进一步集中特征信息,接着看到两个全卷积,即kernel_size=1*1,p=0,stride=1;

可以看到RPN网络实际分为2条线,上面一条通过softmax分类anchors获得positive和negative分类(二分类),下面一条用于计算对于anchors的bounding box regression偏移量,以获得精确的proposal。

而最后的Proposal层则负责综合positive anchors和对应bounding box regression偏移量获取proposals,同时剔除太小和超出边界的proposals。其实整个网络到了Proposal Layer这里,就完成了相当于目标定位的功能。其实就是一个事先准备和预测一些可能有目标的地方的矩形框。

如果想对anchor的详细生成方法,了解更深,可以参考博文:

下面分别看下两条支路的工作原理:

参考博文:

https://zhuanlan.zhihu.com/p/31426458

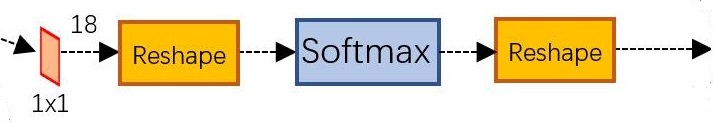

1)softmax判定positive与negative

一副MxN大小的矩阵送入Faster RCNN网络后,到RPN网络变为(M/16)x(N/16),不妨设 W=M/16,H=N/16。在进入reshape与softmax之前,先做了1x1卷积,如图9:

经过该卷积的输出图像为WxHx18大小。这也就刚好对应了feature maps每一个点都有9个anchors,同时每个anchors又有可能是positive和negative,所有这些信息都保存WxHx(9*2)大小的矩阵。为何这样做?后面接softmax分类获得positive anchors,也就相当于初步提取了检测目标候选区域box(一般认为目标在positive anchors中)。那么为何要在softmax前后都接一个reshape layer?其实只是为了便于softmax分类,单独“腾空”出来一个维度以便softmax分类,之后再reshape回复原状。

2)bounding box regression原理

下图所示绿色框为飞机的Ground Truth(GT),红色为提取的positive anchors,即便红色的框被分类器识别为飞机,但是由于红色的框定位不准,这张图相当于没有正确的检测出飞机。所以我们希望采用一种方法对红色的框进行微调,使得positive anchors和GT更加接近。

对于窗口一般使用四维向量 (x,y,w,h) 表示,分别表示窗口的中心点坐标和宽高。对于下图,红色的框A代表原始的positive Anchors,绿色的框G代表目标的GT,我们的目标是寻找一种关系,使得输入原始的anchor A经过映射得到一个跟真实窗口G更接近的回归窗口G',即:

那么经过何种变换F才能从图10中的anchor A变为G'呢? 比较简单的思路就是:

观察上面4个公式发现,需要学习的是 ![]() 这四个变换。当输入的anchor A与GT相差较小时,可以认为这种变换是一种线性变换, 那么就可以用线性回归来建模对窗口进行微调(注意,只有当anchors A和GT比较接近时,才能使用线性回归模型,否则就是复杂的非线性问题了)。

这四个变换。当输入的anchor A与GT相差较小时,可以认为这种变换是一种线性变换, 那么就可以用线性回归来建模对窗口进行微调(注意,只有当anchors A和GT比较接近时,才能使用线性回归模型,否则就是复杂的非线性问题了)。

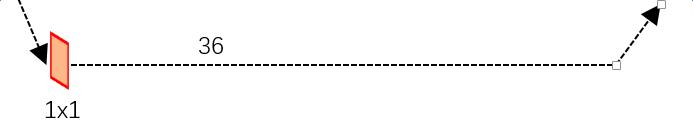

在了解bounding box regression后,再回头来看RPN网络第二条线路,如下图。

可以看到其 num_output=36,即经过该卷积输出图像为WxHx36,在caffe blob存储为[1, 4x9, H, W],这里相当于feature maps每个点都有9个anchors,每个anchors又都有4个用于回归的变换量

![]()

3)RPN的工作原理总结

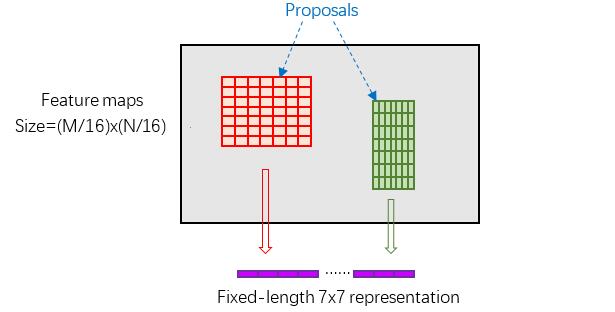

4 ROIPooling

而RoI Pooling层则负责收集proposal,并计算出proposal feature maps,送入后续网络。从下图中可以看到Rol pooling层有2个输入:

- 原始的feature maps

- RPN输出的proposal boxes(大小各不相同)

1)为什么使用RoI Pooling

先来看一个问题:对于传统的CNN(如AlexNet和VGG),当网络训练好后输入的图像尺寸必须是固定值,同时网络输出也是固定大小的vector or matrix。如果输入图像大小不定,这个问题就变得比较麻烦。有2种解决办法:

- 从图像中crop一部分传入网络

- 将图像warp成需要的大小后传入网络

两种办法的示意图如上图,可以看到无论采取那种办法都不好,要么crop后破坏了图像的完整结构,要么warp破坏了图像原始形状信息。

RPN网络生成的proposals的方法:对positive anchors进行bounding box regression,那么这样获得的proposals也是大小形状各不相同,即也存在上述问题。所以Faster R-CNN中提出了RoI Pooling解决这个问题。

2)RoI Pooling是怎么做的

分析之前先来看看RoI Pooling Layer的caffe prototxt的定义:

layer {

name: "roi_pool5"

type: "ROIPooling"

bottom: "conv5_3"

bottom: "rois"

top: "pool5"

roi_pooling_param {

pooled_w: 7

pooled_h: 7

spatial_scale: 0.0625 # 1/16

}

}

其中有新参数pooled_w和pooled_h,另外一个参数spatial_scale认真阅读的读者肯定已经知道知道用途。RoI Pooling layer forward过程:

- 由于proposal是对应MxN尺度的,所以首先使用spatial_scale参数将其映射回(M/16)x(N/16)大小的feature map尺度;

- 再将每个proposal对应的feature map区域水平分为 pooled_w*pooled_h 的网格;

- 对网格的每一份都进行max pooling处理。

这样处理后,即使大小不同的proposal输出结果都是pooled_w*pooled_h 固定大小,实现了固定长度输出。

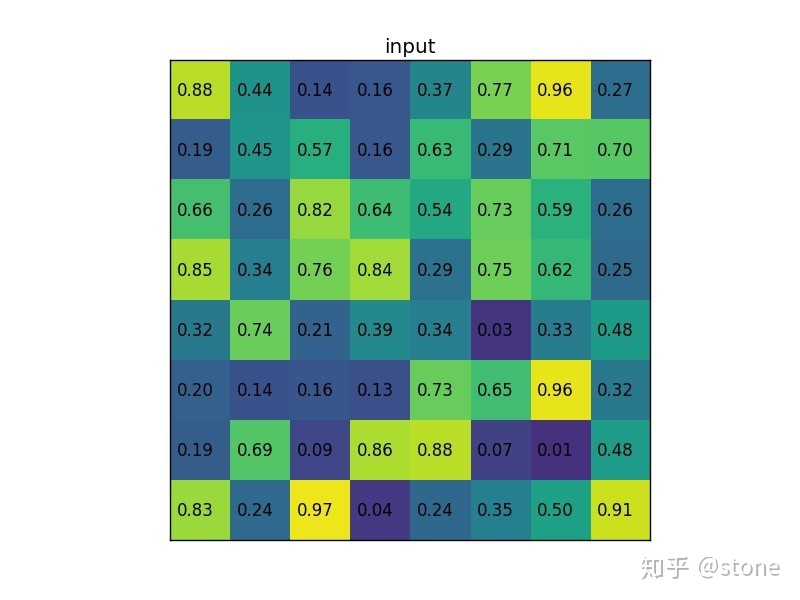

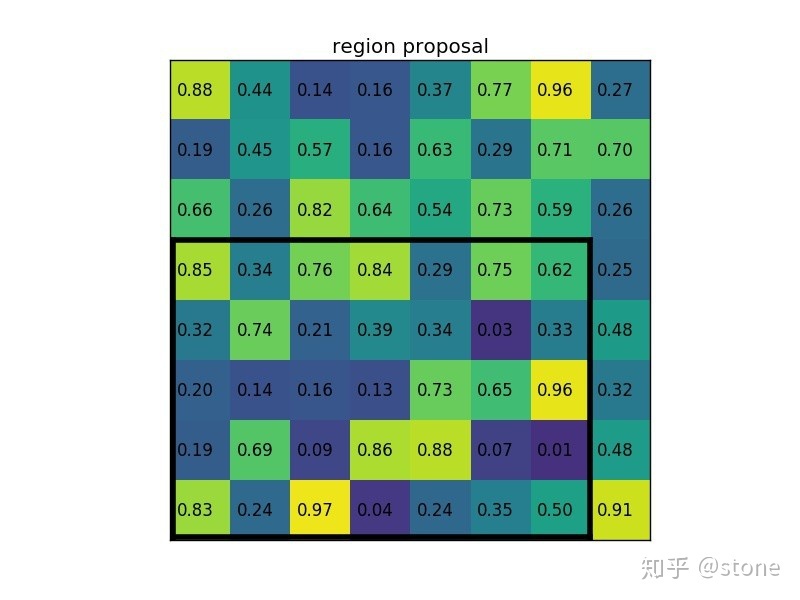

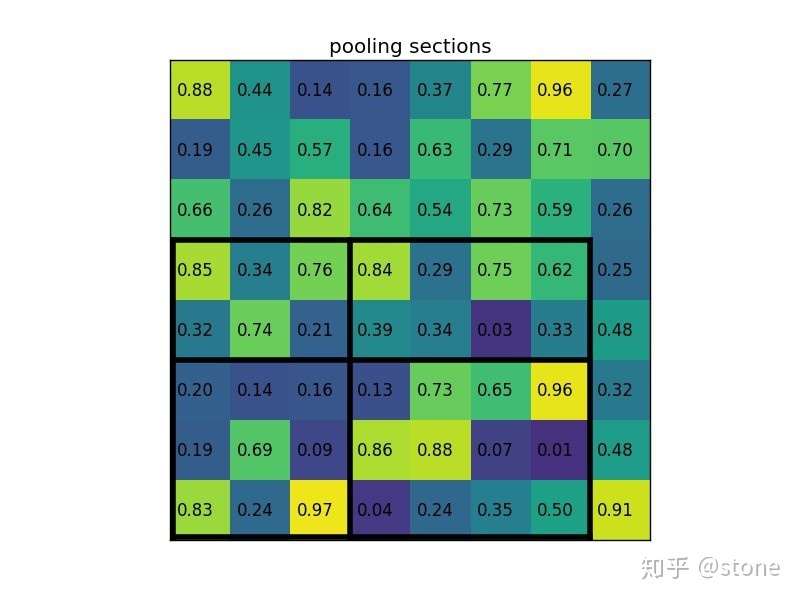

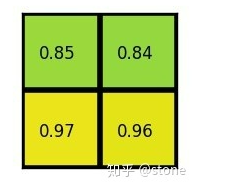

下面用一个实例说明 RoI Pooling的工作原理

假设现在我们有一个8x8大小的feature map,我们要在这个feature map上得到ROI,并且进行ROI pooling到2x2大小的输出。

假设ROI的bounding box为 ![]() 。如图:

。如图:

将它划分为2x2的网格,因为ROI的长宽除以2是不能整除的,所以会出现每个格子大小不一样的情况。

进行max pooling的最终2x2的输出为:

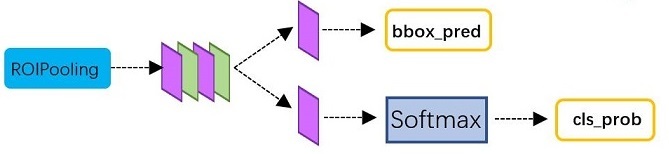

5 分类 (Classification)

Classification部分利用已经获得的proposal feature maps,通过full connect层与softmax计算每个proposal具体属于那个类别(如人,车,电视等),输出cls_prob概率向量;同时再次利用bounding box regression获得每个proposal的位置偏移量bbox_pred,用于回归更加精确的目标检测框。Classification部分网络结构如下图。

从RoI Pooling获取到7x7=49大小的proposal feature maps后,送入后续网络,可以看到做了如下2件事:

- 通过全连接和softmax对proposals进行分类,这实际上已经是识别的范畴了

- 再次对proposals进行bounding box regression,获取更高精度的rect box

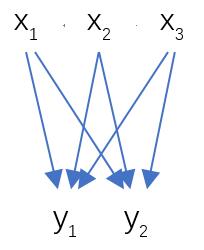

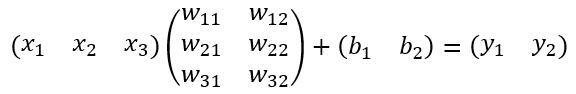

这里来看看全连接层InnerProduct layers,简单的示意图下图,

其计算公式如下:

其中W和bias B都是预先训练好的,即大小是固定的,当然输入X和输出Y也就是固定大小。所以,这也就印证了之前Roi Pooling的必要性。

相关文章

- 05 Classification-学习笔记-李宏毅深度学习2021年度

- 01 机器(深度)学习介绍-学习笔记-李宏毅深度学习2021年度

- 深度学习笔记----matplotlib绘制多个子图(汉字标题,XY轴标签,加x,y刻度,给图上每个点加上数值)& PIL.Image 11行读取文件夹中照片

- 深度学习笔记------现阶段的目标检测器结构解析(Neck[FPN,PANet,Bi-FPN],Head[rpn,yolo...])

- 深度学习优化方法笔记

- 深度学习笔记-----归一化方法BN

- 学习笔记——动手学深度学习(RNN,GRU,LSTM)

- 建造者模式 (学习笔记6)

- linux学习笔记二-----文件权限管理

- [计算机视觉][神经网络与深度学习]R-FCN、SSD、YOLO2、faster-rcnn和labelImg实验笔记

- 【计算机视觉】【神经网络与深度学习】论文阅读笔记:You Only Look Once: Unified, Real-Time Object Detection

- 深度学习笔记之为什么是SoftMax

- ELK学习笔记之简单适用的ES集群监控工具cerebro安装使用

- Prometheus监控学习笔记之prometheus的federation机制

- swift语言的学习笔记十一(willSet与didSet)

- 传智播客 机器学习和深度学习之 Scikit-learn与特征工程 学习笔记

- 2020CADCG会议专题报告深度学习和图像笔记

- Deep Learning(深度学习)学习笔记整理系列之(五)

- ElasticSearch学习笔记 | Mapping映射的创建、修改和删除