《R与Hadoop大数据分析实战》一1.4 Hadoop的安装

本节书摘来自华章出版社《R与Hadoop大数据分析实战》一书中的第1章,第1.4节,作者 (印)Vignesh Prajapati,更多章节内容可以访问云栖社区“华章计算机”公众号查看

现在假定你已经了解了R语言,知道它是什么,如何安装它,它的主要特点是什么,以及为什么要使用它。现在,我们需要知道R的局限性(这样能更好地引入对Hadoop的介绍)。在处理数据前,R需要将数据加载到随机存取存储器(RAM)。因此,数据应该小于现有机器内存。对于数据比机器内存还要大的,我们将其看做大数据(由于大数据还有许多其他定义,这只适用于我们现在所说的例子)。

为了避免这类大数据问题,我们需要扩展硬件配置,但这只是一个临时解决方案。为了解决这一问题,我们需要使用一个Hadoop集群,能够存储大数据并在大型计算机集群进行并行计算。 Hadoop是最流行的解决方案。 Hadoop是一个开源的Java框架,它是Apache软件基金会操作下的顶级项目。 Hadoop的灵感源于Google文件系统和MapReduce,这两项技术主要用于进行分布式大数据处理。

Hadoop主要支持Linux操作系统。若要在Windows上运行它,我们需要使用VMware在Windows操作系统中加载Ubuntu。实际上使用和安装Hadoop的方法有很多种,但在这里我们考虑支持R语言的最佳方式。在我们整合R和Hadoop之前,先来理解什么是Hadoop。

机器学习包含了所有数据建模技术,深入了解这些技术请访问:http://en.wikipedia.org/wiki/Machine_learning。

Michael Noll的Hadoop安装指导博客:Http://www.michael-noll.com/tutorials/running-hadoop-on-ubuntu-linux-single-node-cluster/。

Hadoop使用方式有以下三种模式:

the Standalone mode(单机版模式):在此模式下,不需要启动任何Hadoop后台程序。相反,只需要打开~/Hadoop-directory/bin/hadoop以单一Java进程方式执行Hadoop程序。建议此模式用于测试目的。这是默认模式,无须进行任何其他配置。所有的后台程序,如NameNode、DataNode、JobTracker和TaskTracker都以单一Java进程运行。

the pseudo mode(虚拟模式):在此模式下,需要在所有节点上配置Hadoop。每个Hadoop的组件或守护进程使用一个单独的JAVA虚拟机(JVM),类似于在一个主机上运行最小集群。

the full distributed mode(全分布模式):在此模式下,Hadoop将分布在多台机器中。专用主机根据每个Hadoop节点进行配置。因此,不同的JVM进程对所有的守护进程开放。

Hadoop的安装有几种可行方式,我们将选择与R整合更好的方式。我们将选择Ubuntu操作系统,因为它易于安装和操作。

在Linux、Ubuntu面板(单节点以及多节点集群)上安装Hadoop。 在Ubuntu上安装Cloudera Hadoop。在Linux、Ubuntu面板上安装Hadoop(单节点集群)

要在Ubuntu操作系统安装Hadoop的虚拟模式,需要满足以下先决条件:

使用Sun Java 6

成为专用的Hadoop系统用户

配置SSH

禁用IPv6

以上提供的Hadoop的安装可使用Hadoop MRv1实现。

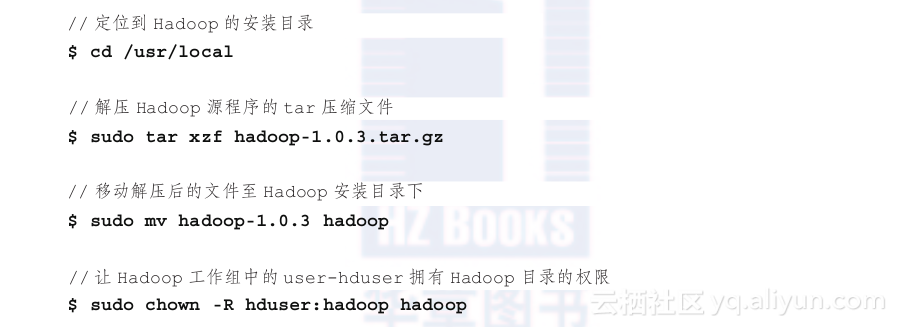

按照以下步骤安装Hadoop。

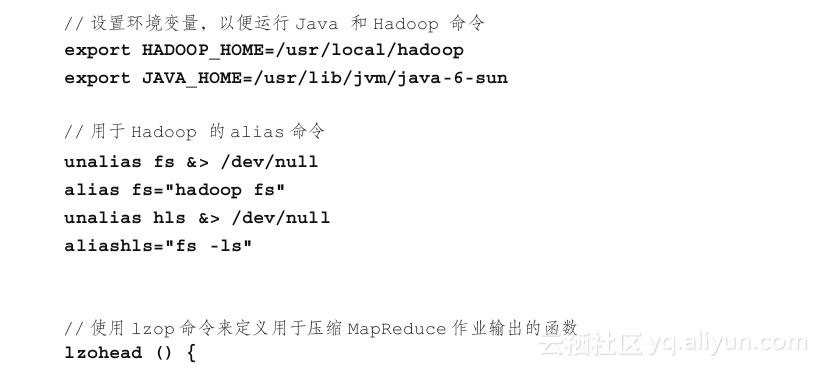

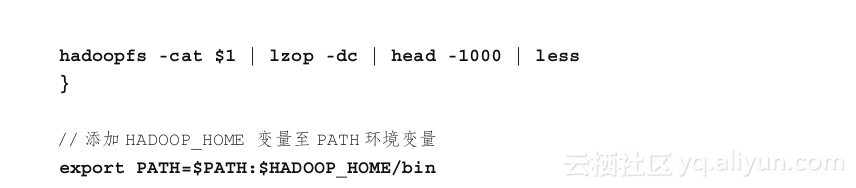

添加$JAVA_HOME和$HADOOP_HOME变量到Hadoop系统用户的.bashrc文件。更新后的.bashrc文件如下:

添加$JAVA_HOME和$HADOOP_HOME变量到Hadoop系统用户的.bashrc文件。更新后的.bashrc文件如下:

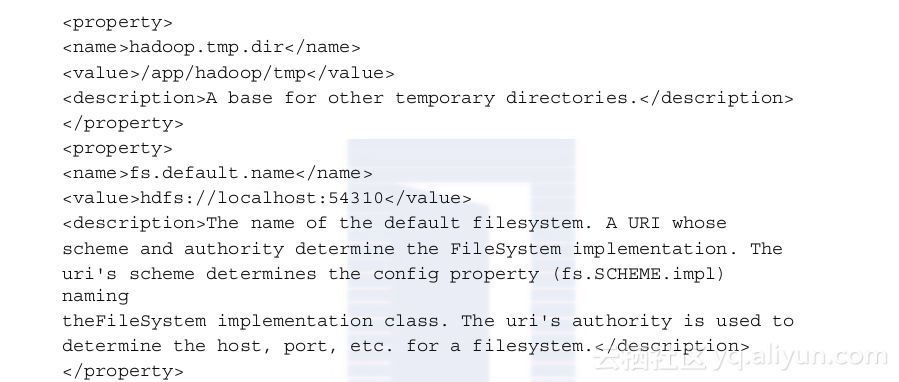

最后,3个文件如下。

conf/core-site.xml:

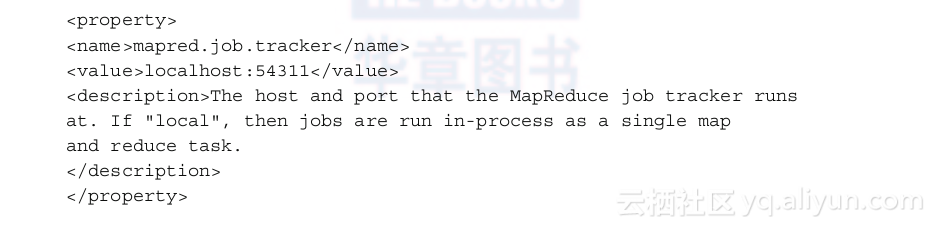

conf/mapred-site.xml:

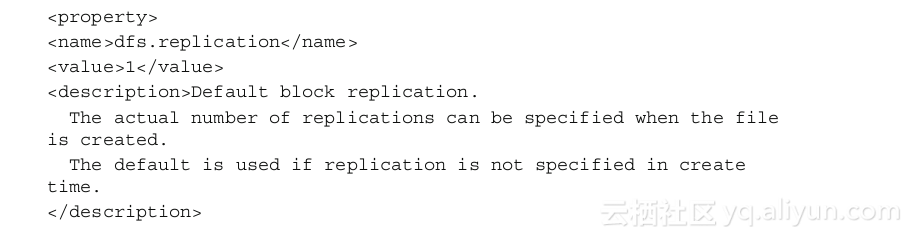

conf/hdfs-site.xml:

完成这些配置文件的编辑后,需要在Hadoop的集群或节点上设置分布式文件系统。

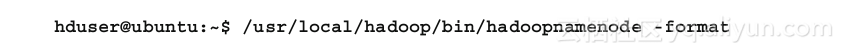

使用下面的命令行通过NameNode格式化Hadoop分布式文件系统(Hadoop Distributed File System,HDFS):

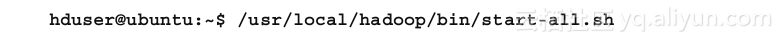

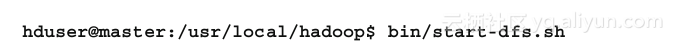

通过使用以下命令行启动单节点群集:

在Linux、Ubuntu面板上安装Hadoop(多节点集群)

我们已经知道如何在单节点集群上安装Hadoop。现在看看如何在一个多节点集群上安装Hadoop(全分布式模式)。

为此,我们需要若干个已经配置好Hadoop单节点集群的节点。为了在多节点上安装Hadoop,我们需要一台已经配置好上一节描述过的单节点Hadoop集群的机器。

当安装好了这个单节点Hadoop集群后,我们需要进行下述步骤:

可以像进行过的单节点集群安装一样进行Secure Shell(SSH)的安装。详细情况可以访问http://www.michael-noll.com。 升级conf/*-site.xml:必须改变所有节点的如下配置文件。

conf/core-site.xml和conf/mapred-site.xml:在单节点集群安装中,已经升级过这些文件。所以,只需在value标签中将localhost改变为master。

conf/hdfs-site.xml:在单节点集群安装中,将dfs.replication的值设成1,现在更新这个值为2。

在格式化HDFS阶段,需要在启动多节点集群前,用以下命令(在主节点)格式化HDFS:

现在,我们已经完成安装一个多节点集群的所有步骤。需要进行以下步骤来启动这个Hadoop集群:

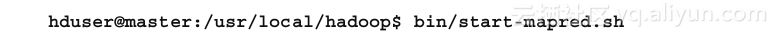

启动HDFS进程: 启动MapReduce进程:

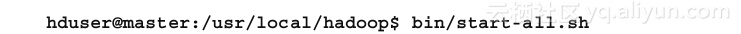

启动MapReduce进程: 通常如下命令启动所有进程:

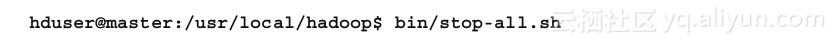

通常如下命令启动所有进程: 停止所有进程:

停止所有进程:

这些安装步骤是受Michael Noll的博客(http://www.michael-noll.com)启发而产生的,他是瑞士的一位研究学者以及软件工程师。他在威瑞信公司担任基于Apache Hadoop的大规模计算框架的技术指导。

现在Hadoop集群已经在机器上创建好了。如果想要使用扩展的Hadoop组件在单节点或者多节点上安装相同的Hadoop集群,可以尝试使用Cloudera工具。

在Ubuntu上安装Cloudera Hadoop

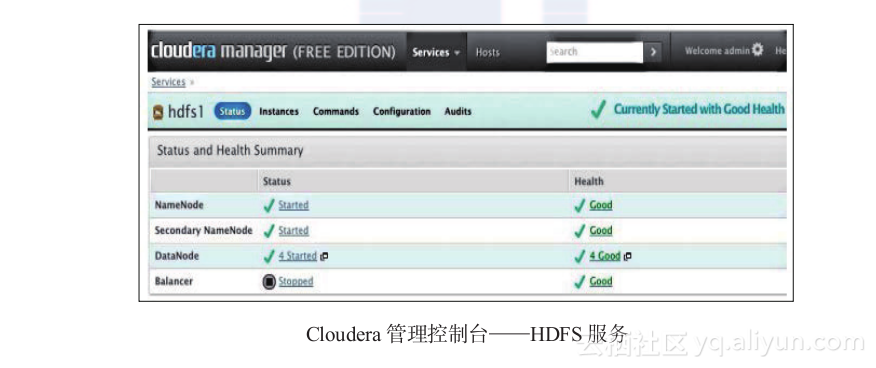

Cloudera Hadoop(CDH)是Cloudera的开源分布式架构,其致力于应用Hadoop技术进行企业级开发。Cloudera也是Apache软件基金会的捐助者。CDH有两个可用的版本:CDH3和CDH4。为了安装其中任何一个版本,都必须使用10.04 LTS版或者12.04 LTS版的Ubuntu(当然,也可以使用CentOS、Debian和Red Hat操作系统)。如果在一个集群上安装Hadoop,可以使用Cloudera管理器简化它的安装过程,这个管理器提供基于Hadoop的GUI界面以及覆盖整个集群的Cloudera组件安装。对于大型集群来说这个工具十分值得推荐。

我们需要满足如下先决条件。

配置SSH

具备以下特征的操作系统:

64位的10.04 LTS版或者12.04 LTS版Ubuntu

Red Hat企业级Linux 5或者Linux 6

CentOS 5或6

Oracle企业级Linux 5

SUSE Linux企业级服务器11(SP1或者lasso)

Debian 6.0

安装步骤如下。

Firefox 11或者更高版本

Chrome

Internet Explorer

Safari

1)如果你已经选择了一个完整的软件版本,安装并验证你的Cloudera管理密钥许可文件。

2)为你的CDH集群装置指定主机名或IP地址范围。

3)使用SSH连接每台主机。

4)在每台群集主机上安装Java开发工具包(JDK)(如果尚未安装)、Cloudera管理代理和CDH3或CDH4。

5)在每个节点上配置Hadoop并启动Hadoop服务。

1)单击齿轮符号图标以显示管理页。

2)打开Password标签。

3)输入新密码两次,然后点击Update。

为了避免这些安装步骤,可以使用预先配置的带有Amazon Elastic MapReduce和MapReduce实例的Hadoop。如果在Windows上使用Hadoop,可以通过Hortonworks尝试HDP工具。这是百分百的开源产品,是企业级分布的Hadoop。可以在http://hortonworks.com/download/上下载HDP工具。

Hadoop的伪分布式安装和配置 SSH免密码配置 (1) 创建一对密钥,命令:ssh-keygen (2)将密钥加入授权 (3)授权以后再通过命令即可实现无密码登录 JDK的安装和配置 (1)进入simple下soft中对jdk进行解压处理 (2)设置环境变量 (3)是环境变量生效 (4)测试是否安装成功 HADOOP安装 (1)hadoop安装包进行解压 (2)编辑配置文件core-site.xml文件 (4)编辑hdfs-site.xml文件 (5)执行格式化 (6)开启进程 (7)输入jps,显示出namenode和datanode一般就成功了

【大数据开发运维解决方案】hadoop+kylin安装及官方cube/steam cube案例文档 对于hadoop+kylin的安装过程在上一篇文章已经详细的写了, 请读者先看完上一篇文章再看本本篇文章,本文主要大致介绍kylin官官方提供的常规批量cube创建和kafka+kylin流式构建cube(steam cube)的操作过程,具体详细过程请看官方文档。

大数据开发之Hadoop 伪分布式安装(4)【完结】 你好看官,里面请!今天笔者讲的是大数据开发之Hadoop 伪分布式安装(4)。不懂或者觉得我写的有问题可以在评论区留言,我看到会及时回复。 注意:本文仅用于学习参考,不可用于商业用途,如需转载请跟我联系。

大数据开发之Hadoop 伪分布式安装(3) 你好看官,里面请!今天笔者讲的是大数据开发之Hadoop 伪分布式安装(3)。不懂或者觉得我写的有问题可以在评论区留言,我看到会及时回复。 注意:本文仅用于学习参考,不可用于商业用途,如需转载请跟我联系。

大数据开发之Hadoop 伪分布式安装(2) 你好看官,里面请!今天笔者讲的是大数据开发之Hadoop 伪分布式安装(2)。不懂或者觉得我写的有问题可以在评论区留言,我看到会及时回复。 注意:本文仅用于学习参考,不可用于商业用途,如需转载请跟我联系。

大数据开发之Hadoop 伪分布式安装(1) 你好看官,里面请!今天笔者讲的是大数据开发之Hadoop 伪分布式安装(1)。不懂或者觉得我写的有问题可以在评论区留言,我看到会及时回复。 注意:本文仅用于学习参考,不可用于商业用途,如需转载请跟我联系。

Hadoop简介、安装 hadoop平台是一个可靠的、可扩展的、可分布式计算的开源软件。 Apache Hadoop平台是一个框架,允许使用简单的编程模型。该平台被设计成可以从单个服务器扩展到数千台服务器,每台服务器都提供本地计算和存储。该平台也被设计成可检测和处理应用层的故障(即高可用、高容错),高可用服务是基于计算机集群的,并且每一台计算机有可能出错。 #### hadoop应用:

相关文章

- centos 7.6 yum 安装mongodg4.4

- hadoop伪分布式安装配置文件hdfs-site.xml

- Kafka-安装使用

- centos安装配置hadoop超详细过程(含故障排除)

- Hadoop程序运行中的Error(1)-Error: org.apache.hadoop.hdfs.BlockMissingException

- ElasticSearch的介绍、安装、基本概念

- Hadoop平台 以Parcel包安装CDH

- Hadoop 2.2.0安装和配置lzo

- Linux安装Hadoop(图文解说详细版)

- npm 安装卸载模块 & ionic插件安装与卸载

- Nginx 安装配置

- 《R与Hadoop大数据分析实战》一1.2 安装RStudio

- composer安装第三方的库packagist.org(laravel框架引入第三方库)

- [置顶] 单机版hadoop实例安装

- hadoop集群监控工具ambari安装

- hadoop平台-Hbase安装

- hadoop(八) - sqoop安装与使用

- hadoop安装

- hadoop(1):centos 安装 hadoop & hive

- 离线安装 Ambari Hadoop