看懂Python爬虫框架,所见即所得一切皆有可能

文章目录

内容介绍

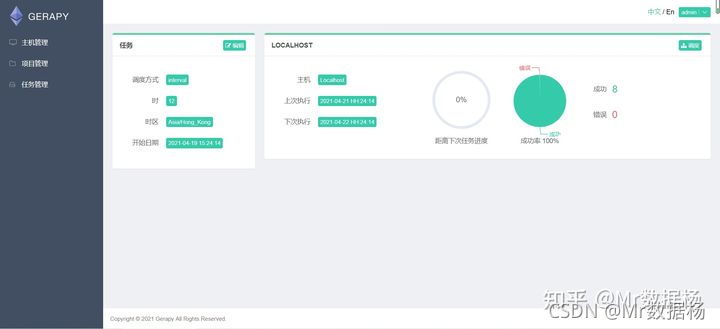

说起Python爬虫,非数据分析或是专业的爬虫工程师都会使用爬虫框架,其中包括 Scrapy、Crawley、Portia、newspaper 等等,但是其中使用占比最高的是 Scrapy框架。顺带说一下光会写爬虫不懂得项目管理的话永远你就是一个兵,所以对于爬虫管理框架来说,首选 Gerapy框架。

来一个知乎本人的高赞回答解释一下这个事情。

Scrapy爬虫框架

首先一定要知道 Scrapy爬虫框架 对新手非常的不友好,或者从某些视频网站上跟着视频学或者说从培训机构里学几天技能掌握的,主要原因有以下两个方面。

框架模块内容太多,虽然只是实现了一个简单的爬虫工作,但是实际上完成一个页面的抓取在框架里最少要走8个以上的步骤,但是这些步骤都是基本都是依靠配置文件完成的,没有丰富的爬虫经验,这些模块很多都不知道是做什么的,也不知道怎么配置。

基于框架内进行数据抓取仅限于那些通用的网站抓取,你就简单理解为一个完成重复工作的机器人就行了。但是如果是那种反爬比较厉害的网站那就是另外一种情况了,完全是爬虫工程师和网站开发者的一个博弈了,所以这种情况不适合任何一种爬虫框架。

对于那些想在工作中摸鱼的Python工程师来说就一定要使用爬虫框架,你会发现省不少力气而且效率真心非常高,不过一切都是在对框架熟练掌握的基础上、和对业务的深刻理解来说来说。

但凡说 Scrapy 无用的基本上没有认真阅读过 Scrapy 的源码,对于 Scrapy框架 中的众多功能在搭建爬虫系统的时候能想到用几个?而且是基本是没有做过大型的爬虫系统项目的。

咱们倒着推这个事,你就知道为什么要用Scrapy框架了。

我之前的单位是国家互联网的新闻中心,做的项目中的有一项是复现863课题舆情监控系统中的内容,使用的方法是 Scrapy爬虫框架 结合 Django Web 搭建的数据采集系统,抓取的目标对象包括新闻、博客、论坛等等,其中每天目标检测网站成千上万,如果不用框架去做这种数据采集得累死。

1.抓取的数据存哪里?

单纯Scrapy爬虫脚本写好了执行抓取任务时数据保存到哪里?ES、Mongodb、MySQL?如果做过开发的人都知道存 Mongodb 中,那些说把数据存到 MySQL 的人基本上99%是从培训机构里出来的,因为大多数培训机构爬虫是不讲 Mongodb 的。通过业务计算逻辑把数据传输到生产 ES 环境中。

在 Centos7.x 上快速搭建 MongoDB 3.4及用户设置

2.几千、几万个爬虫脚本应该怎么管理?

很多刚入行的人都觉得爬虫脚本难写,其实并不是这样。最难的是如何管理密密麻麻数不清的爬虫脚本,这里介绍Python如何处理这个事情。

管理方式无非几种,Web管理环境、GUI管理环境、手动管理环境,不管是哪一种都需要一定的开发基础和管理思路。

在全部文章目录中有相应的文章,自行查找。

3.Scrapy如何面对反爬的?

跟大多数单线抓取某个网站解决其反爬一样,只要把反爬的逻辑设置好,比如最简单的更换代理IP,更换header,解析JS生成cookie访问等等,都可以在框架中设置配置文件。

# 添加Header和IP类

from scrapy.downloadermiddlewares.useragent import UserAgentMiddleware

from scrapy.utils.project import get_project_settings

import random

settings = get_project_settings()

class RotateUserAgentMiddleware(UserAgentMiddleware):

def process_request(self, request, spider):

referer = request.url

if referer:

request.headers["referer"] = referer

USER_AGENT_LIST = settings.get('USER_AGENT_LIST')

user_agent = random.choice(USER_AGENT_LIST)

if user_agent:

request.headers.setdefault('user-Agent', user_agent)

print(f"user-Agent:{user_agent}")

# 添加随机更换IP代理类(根据实际IP代理情况进行修改获取方式和更改方式)

import sys

import requests

sys.path.append('.')

class MyProxyMiddleware(object):

def process_request(self, request, spider):

url = "这里放购买的代理API地址,进行解析后使用代理访问"

html = requests.get(url).text

ip_list = html.split("\r\n")[:-1]

proxy = random.choice(ip_list)

request.meta['proxy'] = 'http://' + proxy

4.如何提高代码编写效率以及数据爬取效率?

一定要阅读源码,一定要阅读源码,一定要阅读源码你才能知道这个框架里到底有什么内容可以用。

相关文章

- 【Python成长之路】python 基础篇 -- global/nonlocal关键字使用

- python(字符串、列表、字典、元组、集合)的常用内置方法

- 小白学 Python 爬虫(38):爬虫框架 Scrapy 入门基础(六) Item Pipeline

- 小白学 Python 爬虫(37):爬虫框架 Scrapy 入门基础(五) Spider Middleware

- 小白学 Python 爬虫(34):爬虫框架 Scrapy 入门基础(二)

- 小白学 Python 爬虫(28):自动化测试框架 Selenium 从入门到放弃(下)

- 小白学 Python 爬虫(6):前置准备(五)爬虫框架的安装

- Python 字符串_python 字符串截取_python 字符串替换_python 字符串连接

- python:ERROR: No matching distribution found for Pillow==9.1.0的处理(Python 3.6.8)

- Python:利用python代码编程实现将视频的avi格式转换为MP4格式

- Python编程语言学习:python中与数字相关的函数(取整等)、案例应用之详细攻略

- 零基础学Python-爬虫-2、scrapy框架(测试案例篇·技术点在后面文章内讲解)【测试将一篇小说的所有访问路径与标题存储到一个文件下】

- 13天搞定python分布式爬虫(视频+项目双管齐下)

- Python爬虫:处理html实体编码

- Python爬虫:scrapy框架Spider类参数设置

- Python编程:命令行python和python -m的区别

- Python爬虫之-Requests

- Python 时间处理

- Python+requests接口自动化测试框架实例教程

- 【Leetcode刷题Python】216. 组合总和 III

- Python: 爬虫入门-python爬虫入门教程(非常详细)

- 一个极为简洁的Python爬虫框架

- 【python】Python实现网络爬虫demo实例

- 【Python实战】 ---- 爬虫 爬取LOL英雄皮肤图片

- Python 爬虫 NO.4 HTTP 响应状态码

- 【Python】3.python实现图片上传到阿里云OSS

- 【从零开始,学会Python爬虫不再难!!!】专栏介绍 | 蓄力计划

- 从零开始,学会Python爬虫不再难!!! -- (14)Scrapy框架丨蓄力计划

- Python爬虫http&https协议(理论)