机器学习面试题——KNN(K Nearest Neighbors)K近邻分类算法

机器学习面试题——KNN(K Nearest Neighbors)K近邻分类算法

提示:

KNN可以说是最简单的分类算法之一,同时,它也是最常用的分类算法之一,

注意KNN算法是有监督学习中的分类算法,它看起来和另一个机器学习算法Kmeans有点像(Kmeans是无监督学习算法),但却是有本质区别的。

那么什么是KNN算法呢,接下来我们就来介绍介绍吧。

KNN介绍一下

人以类聚,物以群分——同流合污,近朱者赤近墨者黑!

KNN的全称是K Nearest Neighbors,意思是K个最近的邻居,

KNN的原理就是:

当预测一个新的值x的时候,根据它距离最近的K个点是什么类别来判断x属于哪个类别。

通过方差表示“距离”

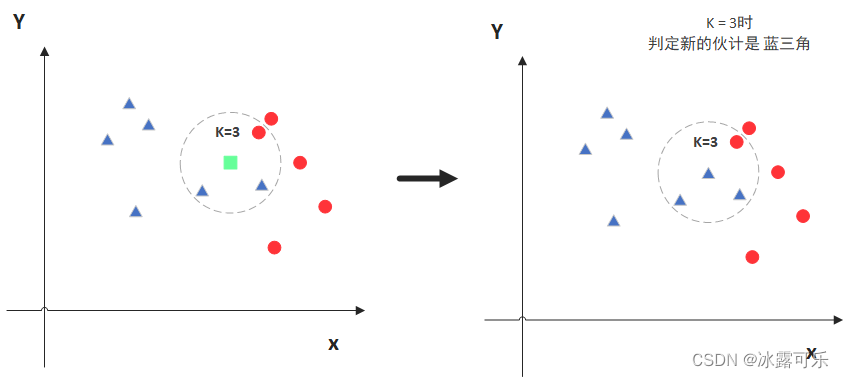

图中绿色的点就是我们要预测的那个点,假设K=3。

那么KNN算法就会找到与它距离最近的三个点(这里用圆圈把它圈起来了),

看看哪种类别多一些,比如这个例子中是蓝色三角形多一些,新来的绿色点就归类到蓝三角了。

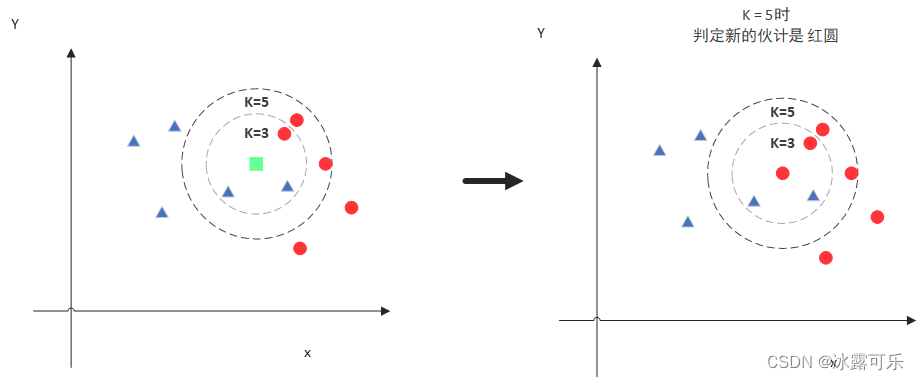

但是呢,当K=5的时候,判定就变成不一样了。

这次变成红圆多一些,所以新来的绿点被归类成红圆。

从这个例子中,我们就能看得出K的取值是很重要的。

距离包括欧式距离和曼哈顿距离

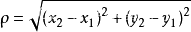

KNN算法中使用更多的是欧式距离,二维空间两个点的欧式距离计算公式如下:

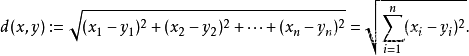

拓展到多维空间,则公式变成这样:

KNN的K值怎么选

答:交叉验证法

尝试:看哪个k更好,通过不断验证K不同的取值来确定。

通过交叉验证(将样本数据按照一定比例,拆分出训练用的数据和验证用的数据,比如6:4拆分出部分训练数据和验证数据),

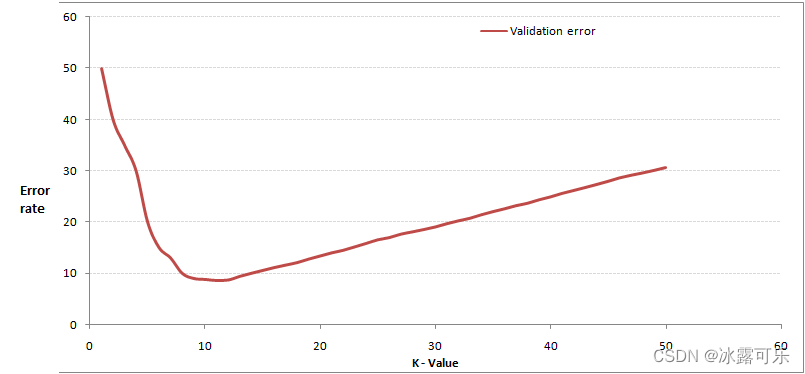

从选取一个较小的K值开始,不断增加K的值,然后计算验证集合的方差,最终找到一个比较合适的K值。

通过交叉验证计算方差后你大致会得到下面这样的图:

选择一个较大的临界K点,当它继续增大或减小的时候,错误率都会上升,比如图中的K=10

又是手肘法?和k-means聚类类似

KNN优缺点

KNN是较为简单的机器学习方法了。最关键的就是理解“距离”的概念。

KNN的优缺点

优点:

(1)简单易用,相比其他算法,KNN算是比较简洁明了的算法。

(2)模型训练快:就没有参数,非参数训练,当然k也算是了。

(3)预测效果好。

(4)对异常值不敏感

缺点:

(1)对内存要求较高,因为该算法存储了所有训练数据

(2)预测阶段可能很慢

(3)对不相关的功能和数据规模敏感

(4)对数据纲量敏感,所以数据要先归一化

KNN数据需要归一化吗?

答:是的

KNN对数据纲量敏感,所以数据要先归一化。

因为KNN使用的方差来反映“距离”,纲量对方差计算影响较大。

KNN三要素说一下

(1)k值的选取

(2)距离度量的方式。 一般为欧式距离

(3)分类决策规则。

分类一般为多数表决,就是哪类多选哪类。

回归为选择平均法,即k个样本输出的平均值作为预测输出。

欧式距离与曼哈顿距离区别

(1)欧式距离:平方差求和再开方

(2)曼哈顿距离:坐标差的绝对值求和

一般用欧式距离而非曼哈顿距离的原因:欧式距离可适用于不同空间,表示不同空间点之间的距离;欧氏距离表示空间中点的距离。

曼哈顿距离则只计算水平或垂直距离,有维度的限制!

knn的k设置的过大会有什么问题

如果选择较大的K值,就相当于用较大领域中的训练实例进行预测,

其优点是可以减少学习的估计误差,

但缺点是学习的近似误差会增大。

我们考虑一种极端的情况,当k和整个样本数量一样的,KNN的分类结果总是取决于样本类别数量最多的那一类。这时模型的误差最大化。

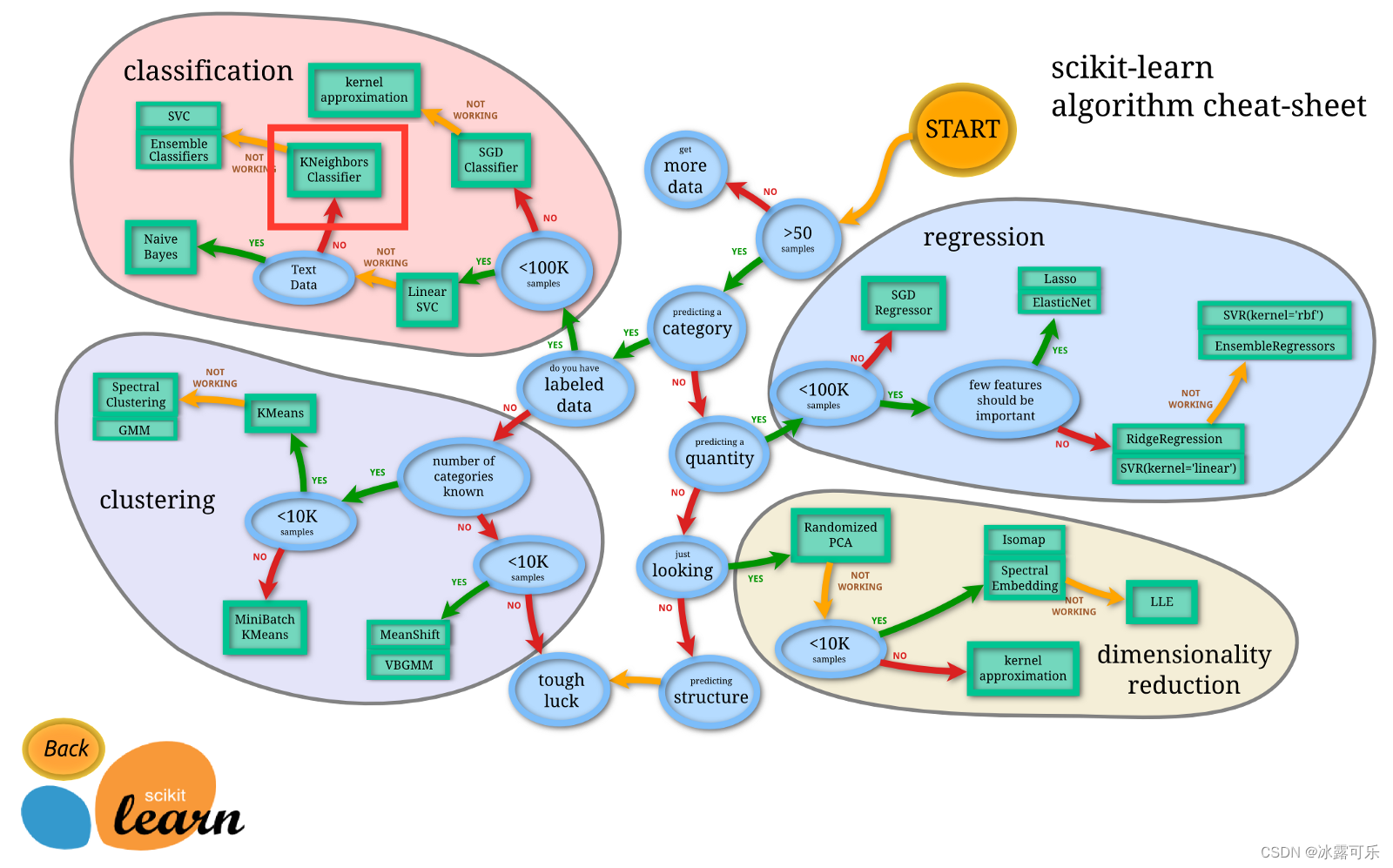

啥时候用啥ML算法?

总结

提示:重要经验:

1)区分K-means:无监督聚类,KNN:(有监督分类)

2)KNN的本质,k值选取,距离计算,优缺点,要了解

相关文章

- X明X源面试题《三》

- 最新最全的Java面试题整理(内附答案)

- (剑指Offer)面试题39:二叉树的深度

- (剑指Offer)面试题29:数组中出现次数超过一半的数字

- 腾讯面试题练习

- 机器学习笔记 - 机器学习基础面试题一

- 前端开发必看100道大厂面试题集锦(一)

- 一道奇怪的JS面试题(一)

- 2022年Android大厂面试题(面经)总结(小红书、快手、爱奇艺、微信、抖音.....)

- PHP面试题:你所知道的php数组相关的函数?

- 【面试】Spring MVC面试题

- 面试题 17.10. 主要元素(C++)

- Leetcode 面试题40. 最小的k个数

- 2022年最新软件测试面试题+答案解析(每日20题,持续更新中)【完结】

- 2021软件测试面试题(持续更新)

- LRU原理和Redis实现——一个今日头条的面试题

- 【机器学习】面试题:LSTM长短期记忆网络的理解?LSTM是怎么解决梯度消失的问题的?还有哪些其它的解决梯度消失或梯度爆炸的方法?

- 面试题系列:MQ 夺命12问,你能扛到第几问?

- 【2023】DevOps、SRE、运维开发面试宝典之RocketMQ相关面试题

- 年后求职高峰期,企业高频面试题和答案都帮你准备好啦..