复盘:智能座舱系列文六- 它的3种交互方式之显式交互(语音以及显示)

复盘:智能座舱系列文六- 它的3种交互方式之显式交互(语音以及显示)

提示:系列被面试官问的问题,我自己当时不会,所以下来自己复盘一下,认真学习和总结,以应对未来更多的可能性

关于互联网大厂的笔试面试,都是需要细心准备的

(1)自己的科研经历,科研内容,学习的相关领域知识,要熟悉熟透了

(2)自己的实习经历,做了什么内容,学习的领域知识,要熟悉熟透了

(3)除了科研,实习之外,平时自己关注的前沿知识,也不要落下,仔细了解,面试官很在乎你是否喜欢追进新科技,跟进创新概念和技术

(4)准备数据结构与算法,有笔试的大厂,第一关就是手撕代码做算法题

面试中,实际上,你准备数据结构与算法时以备不时之需,有足够的信心面对面试官可能问的算法题,很多情况下你的科研经历和实习经历足够跟面试官聊了,就不需要考你算法了。但很多大厂就会面试问你算法题,因此不论为了笔试面试,数据结构与算法必须熟悉熟透了

秋招提前批好多大厂不考笔试,直接面试,能否免笔试去面试,那就看你简历实力有多强了。

它的3种交互方式之显式交互(语音以及显示)

继之前我们介绍智能座舱的隐式交互,今天分享下显式交互,顾名思义就是驾驶员和乘客主动发起与汽车进行互动的方式。

与隐式交互相比,驾驶员和乘客等用户可以通过对话、主动执行任务、手势等方式与智能车辆助手进行显式交互。

智能座舱在主动与用户互动的同时,还需要考虑各种文化和地理因素。

例如,不同的手势在意大利或日本可能意味着不同的东西。

此外,通过分析用户的情绪,智能座舱可以适当地调整其交互方式,从而产生更多的移情交互。

总的来讲显式交互其主要包括以下四个方面:

基于语音的交互

基于显示屏的交互

基于触觉的交互

多模式混合界面交互

基于篇幅我们把显式交互划分为两部分,本文主要是分享语音以及显示交互

基于语音的交互

语音用户界面 (VUI) 可以通过允许驾驶员与车辆进行交互而大大减少驾驶员的分心,

而无需将视线从道路上移开或将手从方向盘上移开,并减少视觉认知负荷。

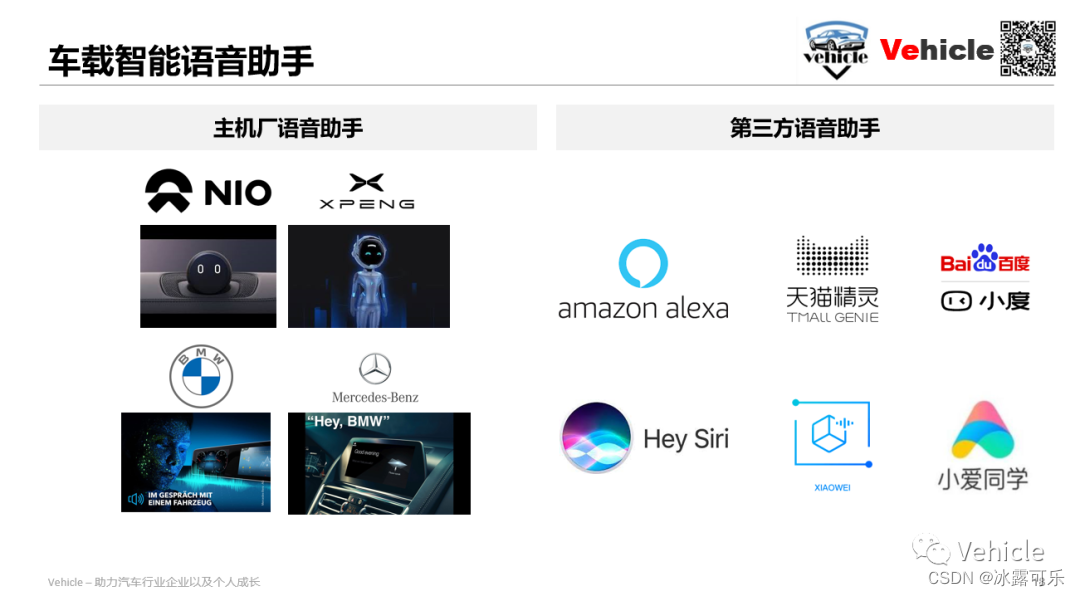

当前语音交互分主机厂自己的,还有集成第三方助手

当前主机厂自己的语音助手如我们之前介绍蔚来的Nomi,

小鹏的小P(小鹏的自动驾驶XPILOT以及智能座舱Xmart OS)

还有宝马的,带有“嘿,宝马!”的 BMW 智能个人助理。

奔驰的MBUX语音助手,当然还有我们之前文章Nvidia英伟达的 AI 智能汽车信仰中介绍的Drive concierge。等

集成的第三方助手,例如国内的天猫精灵,百度的小度等,例如国外的 Amazon Alexa 和 Apple CarPlay。

数字语音助手 (VA) 需要理解以自然方式提供的命令,

而不依赖于需要对用户进行事先培训的预定义关键词。

车载功能,如信息娱乐、气候控制、通话或发送短信等通信、车辆状态(如剩余燃料),甚至通过与其他语音助手同步提供车外帮助。

导航是最常用的 智能语音任务之一,其中驾驶员可以在旅途中请求导航方向,而无需在触摸屏控制台上键入内容,也无需在安全关键驾驶条件下查看显示路线。

在长途驾驶中,尤其是在夜间,众所周知,与前排座位上的同伴交谈有助于保持驾驶员的警觉和清醒。

然而,增加驾驶员认知负荷的对话(例如手机对话)可能不利于驾驶员的警觉性。

此外,被动倾听可能不如主动参与对话有效。

因此,已经进行了研究,其中驾驶员和 VA 进行随意的对话,

而不是语音命令的信息收集序列,并且已经表明它可以有效地防止驾驶员分心。

研究表明,与 VA 进行短暂的间歇性对话有助于提高驾驶员的警觉性。

此外,已经进行了基于驾驶模拟器的研究,以表明 VA 应该提供自信的声音来吸引驾驶员的注意力。Large 等人的工作提供了设计对话 VA 以使驾驶员参与自然对话的指南。

语音助手还可以帮助提醒驾驶员注意迎面而来的紧急车辆。

警报器是由警车、救护车和消防车等紧急车辆发出的独特声音。

紧急车辆发出警报声,提醒其他车辆和行人让路。

由于现代汽车的驾驶员分心或隔音,驾驶员可能不知道迎面而来的紧急车辆。

基于声学的紧急车辆检测方法并为驾驶员提供声学和/或视觉警报是解决问题的一种方法。

Meucci 等人在工作中开发了一种通过基于信号处理的音高检测算法的初始实时警笛检测系统。

先前关于警报器检测的工作已扩展到声源定位,并向靠近声源的驾驶员提供警报。

提出了一种基于 CNN 的集成模型,用于将交通声景分类为噪声、警笛声和其他车辆声音。

该方法展示了 96% 的准确度,即使是短 0.25 秒的样本也能正确分类紧急警报器。

人车交互的一大挑战是从 3 级驾驶到手动控制的 TOR(响应时间),

考虑到驾驶员的情境意识和分心程度,其中语音助手可能很有用。

已经对驾驶员在有和没有 语音的情况下发出 TOR 后进行控制所花费的时间进行了研究。

语音 提供了关于交通状况、信息娱乐建议和日历事件提醒的对话式讨论。

这些研究是在驾驶模拟器中进行的,结果表明 语音帮助及时接管了 39%。

因此,其他研究也评估了在 3 级自动驾驶期间使用对话式语音进行接管请求。

该研究表明,基于倒计时的简单界面在可用性和感知接受度方面排名最高,

但参与度最低,他们提出了 TOR 基于对话的交互设计指南。

但语音交互由于其顺序性和时间性而存在固有问题。

轮流或者打断问题很常见,其中用户不确定语音助手是否正在倾听或准备响应。

用户还需要依赖本质上是短暂的短期记忆。

当驾驶员需要在主要任务和三级任务之间执行多项任务时,

这种对短期记忆的依赖可能会在驾驶任务期间产生问题。

此外,用户抱怨在访问特定菜单等语音交互过程中缺乏控制。

这激发了 下一节中讨论的多模式交互的使用。

基于显示屏的交互

我们在之前的智能座舱系列文二- 它背后的5种交互技术之视觉。

文中提到当前大屏时代,所以显示交互例如HMI都非常重要,

当前显示输入可以是传统的基于按钮和旋钮、基于触摸屏的交互、语音交互或基于手势的交互。

当前车载显示主要分三种:

普通屏幕显示

3D屏幕显示

AR 抬头显示

通屏幕显示目前已经普及,目前HUD,特别是AR-HUD 和 HMD是发展的方向和重点,

将信息丰富的虚拟元素与真实场景融合在一起,防止驾驶员将视线从道路上移开。

HUD 通常用于高速驾驶,因此驾驶员在通过交通时无需将视线从道路上移开。

正如人们想象的那样,对于 HUD 和 HMD 来说,

将对象或线索固定到现实世界场景中,头部姿势跟踪和注册是必要的。

配准方法能够以精确的方式将虚拟对象/文本固定到真实世界的场景中。以下是必要的而且是难点:

1)车辆的绝对位置以及姿态,

2)头部和眼睛相对于车辆坐标系的相对位置和方向,以及

3)识别和跟踪车辆外部的物体(例如车辆) .

我们在之前提供了关于头部姿势估计的详细描述 。

配准算法需要是实时的,以防止视觉延迟问题,适应车辆振动、快速的头部或眼睛运动以及来自真实场景的遮挡。

提出了一种实时配准算法,AR HUD 应用的平均配准时间为 0.0781 秒,从而避免了视觉延迟问题。车辆振动可能会导致注册问题,

并提出了一种在大振动期间从 HUD 隐藏虚拟对象的方法。

Jiang 等人的工作对基于 AR 的系统的注册方法进行了全面审查。

AR HUD 还提出了独特的照明和色彩混合挑战。

与汽车应用一样,在白天和夜间驾驶期间,环境光的变化很大,需要在 AR HUD 中进行补偿才能让驾驶员看到。

为了解决这个问题,设计了一种主动策略,该策略对背景场景和环境光进行采样,

以自适应地调整显示的 AR 图像的亮度和颜色。

此外,在设计显示元素时,杂波起着至关重要的作用,如果设计不当,可能会对可用性产生负面影响。

此外,HUD 中的意外遮挡可能会导致事故,

其中虚拟对象直接放置在驾驶员的视线中并遮挡了前方的真实场景。

因此,强大的配准算法对于部署沉浸式和信息丰富的 HUD/HMD 是必要的。

3D显示器可用于提供被动 3D 格式的显示信息。

可以通过自动立体显示器提供警报和其他必要信息,因为已知 3D 信息可以更快地吸引人类注意力。

例如,已经进行了研究以调查汽车仪表板中自动立体显示器的使用,

并发现用户在使用类 3D 显示器的次要任务中表现更好。

这些研究为将 S3D 显示器整合到车辆中提供了指导。

还有一个权衡,因为复杂的显示器对驾驶员来说更具吸引力和身临其境,但会增加对主要任务的分心。因此,在结合3D显示器时需要考虑适当的设计。

基于触觉的交互

多模式混合界面交互

总结

提示:重要经验:

1)3种交互方式之显式交互(语音以及显示)

3)笔试求AC,可以不考虑空间复杂度,但是面试既要考虑时间复杂度最优,也要考虑空间复杂度最优。

相关文章

- 社区智慧+机器智能=奇虎经验的知识机器人

- Android智能聊天机器人

- 《阿里云周刊》第2期:阿里绿色智能数据中心落户张北,将成北方数据心脏

- 智能优化算法——蜜蜂优化算法(Matlab完整代码实现)

- nlp序列完全可以模拟人脑智能

- 现代神经网络要这么用才能创造智能

- Volcano:在离线作业混部管理平台,实现智能资源管理和作业调度

- 【华为云技术分享】华为云“智能数据湖”解决之道

- 智能优化算法应用:基于GWO优化的二维最大熵图像阈值分割 - 附代码

- 智能优化算法:战争策略算法-附代码

- 智能优化算法:混沌博弈优化算法-附代码

- 智能优化算法:足球联赛竞争算法-附代码

- C++11 智能指针

- RK3399平台开发系列讲解(项目实践篇)1.2、家用智能摄像头项目框图

- Python基于OpenCV的智能交通灯系统(南北车流量比例)[源码&部署教程]

- ❸OAK智能深度相机如何实现低延迟?

- OTA系列小问答:智能汽车得以OTA常态化的背后因素是什么?对车厂和车主分别意味着什么?