注意力公式步骤每一步的含义,总共三步

步骤 一步 含义 公式 注意力 三步

2023-09-14 09:14:43 时间

Transformer - Attention is all you need - 知乎

熬了一晚上,我从零实现了Transformer模型,把代码讲给你听 - 知乎

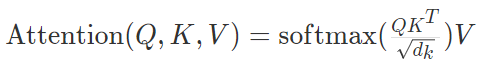

q,k,v分别是query,key,value,对于encoder self-attention,第一次计算的初始值是每个字的embedding,

1、q用来和k做点乘计算相似度,

2、这些相似度经过softmax变成权重,

3、然后权重和v相乘,其实就是v的一个加权平均。

如果是encoder-decoder attention,q是decoder的hidden state,k和v是encoder各个位置的hidden state。

相关文章

- SSH(Spring+Struts2+Hibernate)框架搭建步骤(含配置文件以及运行结果)

- 简单实例讲解linux的module模块编译步骤

- iOS 自定义步骤进度条

- maven上传jar包到nexus私服后的存放路径 以及 使用IDEA上传jar包的步骤

- 卸载oracle步骤

- 【Teradata】DSA服务器tdactivemq重启清理消息队列步骤

- spss进行判别分析步骤_spss判别分析结果解释_spss判别分析案例详解

- [转]iOS 应用内付费(IAP)开发步骤

- 【Ubuntu16.04 】安装gRPC详细步骤(cmake>=3.13)

- 【Android 逆向】函数拦截原理 ( 可执行程序基本结构 | GOT 全局偏移表 | 可执行程序函数调用步骤 )

- Linux环境中Clamav杀毒软件详细使用步骤

- 【MySQL笔记】mysql来源安装/配置步骤和支持中国gbk/gb2312编码配置

- LoadRunner性能测试基本步骤

- Linux系统安装最新python详细步骤与问题解决方法【Ubuntu】

- 擎创技术流 | ckman教程(3)CKman源码分析部署集群的主要步骤