TTSR再次理解,主要是针对Texture Transformer TT的全部过程的一个梳理

Proposed Method

因此,文章基于注意力机制,提出了一个纹理 Transformer 网络(TTSR),最大程度地利用了参考图像的信息,它可以有效地搜索与迁移高分辨率的纹理特征到低分辨率图像中,解决纹理模糊和纹理失真的问题。网络的主要两个部分:

- 纹理转换器 (Texture Transformer )TT :把Ref图像中的HR纹理迁移到LR图像中

- 跨尺度特征集成模块(Cross-Scale Feature Integration) CSFI:融合不同尺度的纹理特征,提高SR图像质量

1.Texture Transformer TT

下面这幅图展示了TT的结构,它有四个输入图像,LR↑ 通过bicubic x4上采样,Ref↑↓先经过bicubic x4下采样再通过bicubic x4上采样,以和LR↑保持domain-consistent 域一致性,这样做将有利于纹理搜索。为啥先下采样再上采样?因为K起的作用就是建立参考图和LR图的关联关系,评估哪些地方像,相似的地方借鉴Ref的纹理。

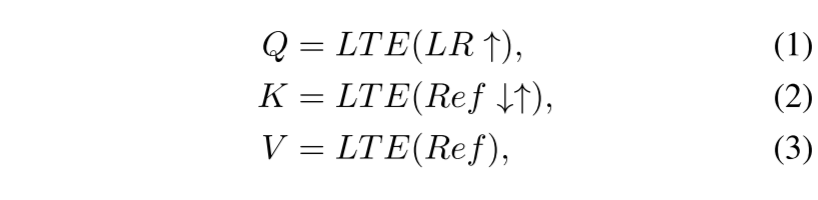

1)learnable texture extractor (LTE):

用于提取纹理特征,用VGG预训练模型的前几层作为网络结构,但是它是可学习的,随着 Transformer 的训练不断更新自己的参数。LR上采样 、Ref上下采样、Ref经过LTE得到纹理信息定义为Q、K、V ,Q、K用来进行纹理搜索,V用来进行纹理迁移。

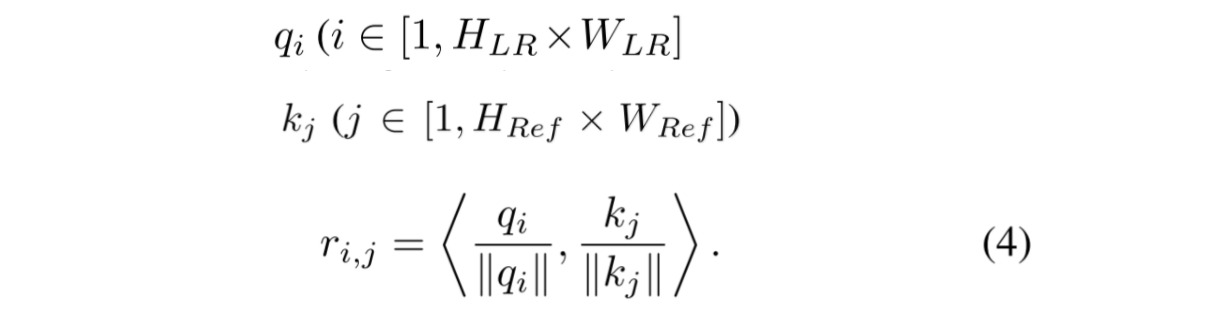

2)relevance embedding module:

用来估计Q和K之间的相似性从而建立LR和Ref图像的相关性,把Q和K unfold 为特征块,表示为qi和kj,以内积的方式计算 Q 和 K 中的特征块两两之间的相关性。内积越大的地方代表两个特征块之间的相关性越强,可迁移的高频纹理信息越多,反之则相反。

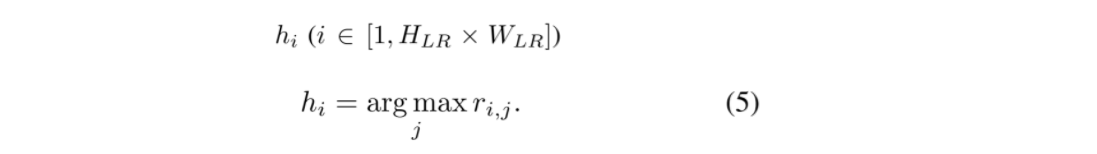

3)Hard-Attention:

利用上面计算得到的相关性信息,计算硬注意力图,它记录了对 Q 中的每一个特征块,K 中对应的最相关的特征块的位置。接下来,就可以利用硬注意力图中所记录的位置,从 V 中迁移对应位置的HR纹理特征,得到纹理特征图 T,T 的每个位置包含了参考图像中最相似的位置的高频纹理特征。

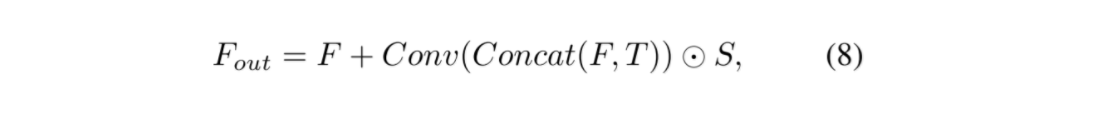

4)Soft-Attention:

同理,利用相关性信息,计算软注意力图S,和硬注意力图H不同的是,它记录的不是位置而是,K中最相关的特征块的具体相关性,即内积大小,它表示T中每个位置已迁移纹理特征的置信度,置信度越高即相关性强的texture赋予的权重越大,使得迁移的高频纹理特征得到更准确的利用。

最后将骨干网络中得到的特征F和纹理特征图T在通道上进行级联,通过一个卷积层和软注意力图进行内积,在加回到F中,得到最终的融合特征。

2.Cross-Scale Feature Integration (CSFI)

为了进一步提高生成图像的质量,将texture transformer进行堆叠,输出三种尺度(1×,2×和4×)的特征,不同尺度的参考纹理特征从不同深度的LTE中提取得到,通过CSFI进行特征融合。每次将LR特征上采样到下一个尺度时,会应用CSFI模块。在模块的内部中,每个尺度层接收其它尺度层经过上/下采样的特征,如下图所示,Upsample和Downsample用的是bicubic.

相关文章

- Scala中List(Map1,Map2,Map3 ....) 转成一个Map

- 【转载】Python脚本判断一个数是否为素数的几种方法

- ansible shell模块:创建一个空文件

- JVM 调优实战--一个案例理解常用工具(命令)

- 一个详尽的面向 SAP UI5 初学者的教程 - 如何在 SAP UI5 中绘制图表 Chart

- Atitit 资源类型的分类法规范MIME类型类型 目录 1.1. 一个MIME类型至少包括两个部分:一个类型(type)和一个子类型(subtype)。1 1.2. 命名格式MIME类型包括一个

- 用一个实际例子理解Docker volume工作原理

- SAP UI5 FileUploader 控件深入介绍 - 为什么需要一个隐藏的 iframe 试读版

- 通过现实生活中一个例子来理解 JavaScript Promise

- 通过rxjs的一个例子, 来学习SwitchMap的使用方法

- 通过一个最简单的例子,理解Angular rxjs里的Observable对象的pipe方法

- HTML+CSS网页制作:一个简易美观的登录页面实例代码

- SQL Editor and reconnect【mysql(workbench)更新数据时候的一个异常】【Error Code:1175】

- 一个基于matlab的标准PSO粒子群优化算法仿真

- hadoop 开始时间datanode一个错误 Problem connecting to server

- NLP模型笔记2022-04:一个简单案例理解语言模型预测句子的原理

- 一个实例彻底理解Transformer模型中的BLEU值评价指标

- mDNS原理的简单理解——每个进入局域网的主机,如果开启了mDNS服务的话,都会向局域网内的所有主机组播一个消息,我是谁,和我的IP地址是多少。然后其他也有该服务的主机就会响应,也会告诉你,它是谁,它的IP地址是多少

- 内部类是指在一个外部类的内部再定义一个类。