最小二乘支持向量机分类器

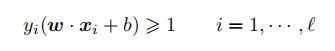

支持向量机最初是基于这样的设想:将数据映射到高维空间,并在该空间中构造一个最优的分割超平面,即最大化“安全”间隔。为了使数据点安全地正确地落在超平面的两侧,有如下不等式:

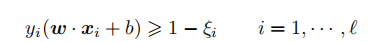

再通过添加违反约束 ξi 修正为:

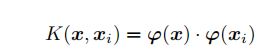

最大化间隔就是最小化 ||w||。对偶凸二次规划(QP)可以得到最优值,就像 MLP 和其他技术一样,不会收敛到一个局部极小值。当研究者都追随着 SVM/凸二次规划的热潮时,有两个问题却未引起关注。第一个问题是如何选择适当的核。具有良好泛化能力的线性可分器需要恰当地度量训练样本及测试样本的相似性:

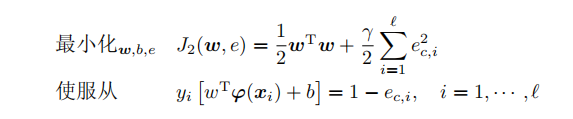

第二个问题是计算效率。二次规划是可解的,但是在求解许多大规模问题时,CPU 所花费的时间会迅速增长。采用二次规划是因为存在不等式的约束,所以尝试舍弃不等式约束而得到更简单的等式约束是值得的。使用等式约束并对误差进行平方形式的罚分,将能得到类似之前良好的线性等式,可以更快地解决问题,也便于理解。

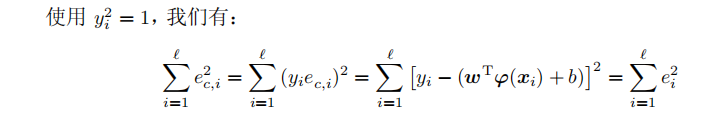

SVM 分类器的最小二乘变体可以通过改写 SVM 中的最小化问题得到:

其实通过

γ

\gamma

γ,我们就可以知道调节

γ

\gamma

γ的值可以决定,训练的时候,我们是希望最大软间隔大一点,还是希望误差平均项小一点。这对我们的模型有着很大的影响,一般来说合适的软间隔有着很好的泛化能力,而均方误差项小一点,则对训练集有着更好的拟合能留,所以,对于

γ

\gamma

γ如何调节,我们要根据具体问题来定。

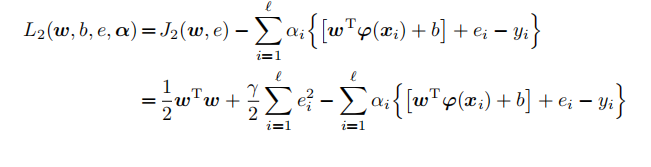

我们可以通过构造如下拉格朗日函数来求解 LS-SVM 的回归量:

对于拉格朗日函数,博主最近推导了,以后准备专门出一篇拉格朗日函数的仔细讲一下,这个函数在机器学习还是深度学习都有着十分重要的作用。

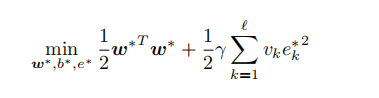

另外,有一个很有趣的例子,对于误差回归项,如果我们有一个离群值,那么误差的平方将会更大,这对于我们的模型则会有着很大的影响,所以,我们需要进行离群值的过滤,同样我们也可以给予离群值一个很小的平方误差权重,事实上这就出现了健壮加权最小二乘支持向量机如下:

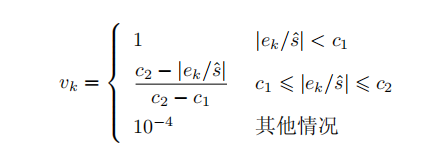

权重

v

k

v_k

vk 的选择主要基于(非加权)LS-SVM 中的误差变量

e

k

=

α

k

/

γ

e_k = α_k/γ

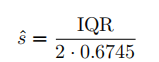

ek=αk/γ。首先得到 sˆ,然后

就可以得到 LS-SVM 中误差变量 ek 标准求导的一个稳健估计:

四分位差(IQR)为较大的四分位数与较小的四分位数之差,显然,类似于离群值的极端数据不在该估计范围内,所以这种方法是健壮的。具体来说,稳健估计 [91] 可以通过计算下式得到:

常数

c

1

和

c

2

通

常

取

c

1

=

2.5

和

c

2

=

3

c_1 和 c_2 通常取 c_1 = 2.5 和 c_2 = 3

c1和c2通常取c1=2.5和c2=3,这是考虑到高斯分布中,残差的值很少有超过 2.5s^的,所以那些在高斯分布中过大的误差变量将会被赋予越来越小的权重。

最小二乘支持向量机,结合力最小二乘法和支持向量机,而健壮加权最小二乘支持向量机则又在其基础上进行了加权优化,事实上,这样的算法思想更值得借鉴,希望在学习建模的过程中,多学习新的思路,并学为己用,将会给我的建模能力得到很大的提升。

相关文章

- H7-TOOL发布V2.18,脱机烧录新增芯海,辉芒微,武汉芯源,领芯等,支持了扫描枪,带来LUA写文件API,可以做日志或者数据记录了

- 犀牛Rhino 7.26激活版免费下载安装教程 支持VRay 6 渲染器

- 【鸿蒙 HarmonyOS】HarmonyOS 开发环境搭建 ( 下载 | 安装 | 启动 | 支持的设备与开发语言 )

- SQLServer 错误 8651 未能执行所请求的操作,因为可用内存少于最小查询内存。 请减小“每次查询占用的最小内存”服务器配置选项的配置值。 故障 处理 修复 支持远程

- SQLServer 错误 8680 内部查询处理器错误:查询处理器在处理远程查询操作过程中遇到意外错误。 故障 处理 修复 支持远程

- SQLServer 错误 41349 警告:为包含具有持续性 SCHEMA_AND_DATA 的一个或多个内存优化表的数据库启用了加密。 不会对这些内存优化表中的数据加密。 故障 处理 修复 支持远程

- Mybatis3.2不支持Ant通配符TypeAliasesPackage扫描的解决方案详解编程语言

- JSP application.getMinorVersion()方法:返回服务器支持的Servlet API最小版本号

- PayPal与Venmo将很快支持第三方加密货币钱包

- MySQL新增支持分区功能,数据库性能提升明显(mysql支持分区)

- MySQL 数据库支持两位小数点精度存储(mysql两位小数点)

- 揭秘Redis如何设置支持长短连接(redis设置长短连接)

- 中兴随身 WiFi6 5G 便携路由器将正式登陆国内市场:支持 32 个用户同时上网与中国广电 700M 频段