Docker 自定义容器网络

CNM&libnetwork

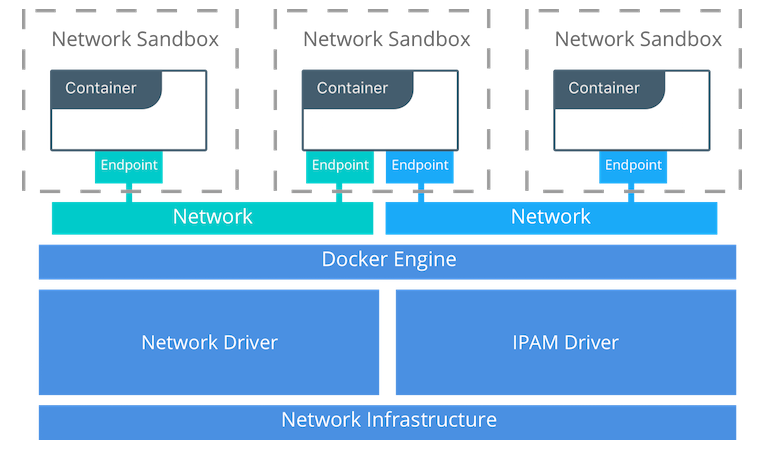

libnetwork是Docker团队将Docker的网络功能从Docker的核心代码中分离出来形成的一个单独的库,libnetwork通过插件的形式为Docker提供网络功能。基于代码层面再升华一下,可以将docker的网络抽象出一个模型来,就叫CNM(Container Networking Model),该模型包含三大块:

- Sandbox:容器的网络栈,包含interface,路由表,DNS设置等,可以看做就是linux network类型的namespace本身,该有的网络方面的东西都要有,另外还包含一些用于连接各种网络的endpoint

- Endpoint : 用来将sandbox接入到network中。典型的实现是Veth pair技术(Veth pair是Linux固有的,是一个成对的接口,用来做连接用)

- Network : 具体的网络实现,比如是brige,VLAN等,同样它包含了很多endpoint(那一头)

一句话:sandbox代表容器,network代表容器外的网络驱动形成的网络,endpoint连接了二者

另外,CMN还提供了2个可插拔的接口,让用户可以自己实现驱动然后接入该接口,支持驱动有两类:网络驱动和IPAM驱动,看看这俩类驱动干什么的?

-

Network Drivers: 即真正的网络实现,可以为Docker Engine或其他类型的集群网络同时提供多种驱动,但是每一个具体的网络只能实例化一个网络驱动。细分为本地网络驱动和远端网络驱动:

- 本地网络驱动:对应前面说到的原生网络

- 远端网络驱动:对应前面说的自定义网络

- IPAM Drivers — 构建docker网络的时候,每个docker容器如果不手动指定的话是会被分配ip地址的,这个分配的任务就是由该驱动完成的,同样的,Docker Engine还是给我们提供了缺省的实现。

整个的原理模型图如下,参见官网:

如何自定义容器网络?

除了none,host,bridge这三个自动创建的网络,用户也可以根据业务需要创建 user-defined 网络。

Docker 提供三种 user-defined 网络驱动:bridge, overlay 和 macvlan。overlay 和 macvlan 用于创建跨主机的网络,我们后面有章节单独讨论。

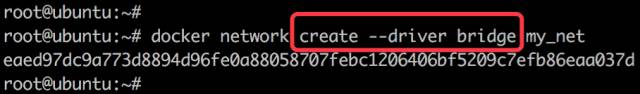

我们可通过 bridge 驱动创建类似前面默认的 bridge 网络,例如:

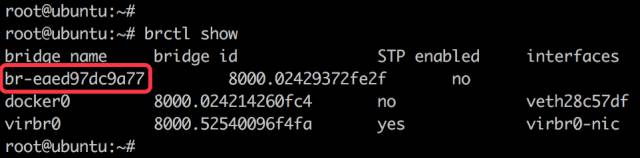

查看一下当前 host 的网络结构变化:

新增了一个网桥 br-eaed97dc9a77,这里 eaed97dc9a77 正好新建 bridge 网络 my_net 的短 id。执行 docker network inspect 查看一下 my_net 的配置信息:

这里 172.18.0.0/16 是 Docker 自动分配的 IP 网段。

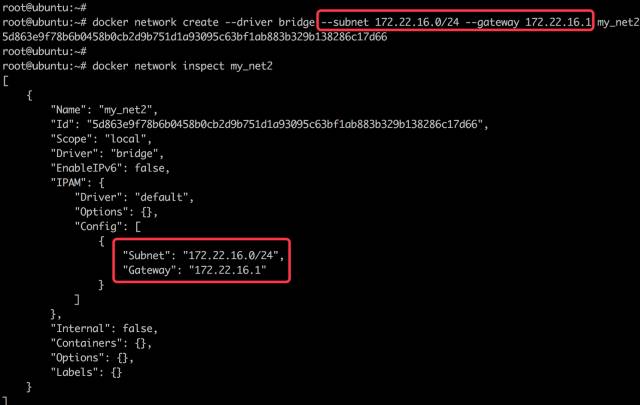

我们可以自己指定 IP 网段吗?

答案是:可以。

只需在创建网段时指定 --subnet 和 --gateway 参数:

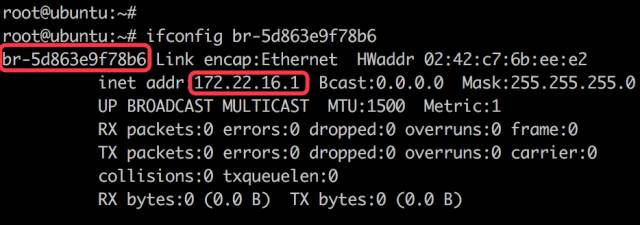

这里我们创建了新的 bridge 网络 my_net2,网段为 172.22.16.0/24,网关为 172.22.16.1。与前面一样,网关在 my_net2 对应的网桥 br-5d863e9f78b6 上:

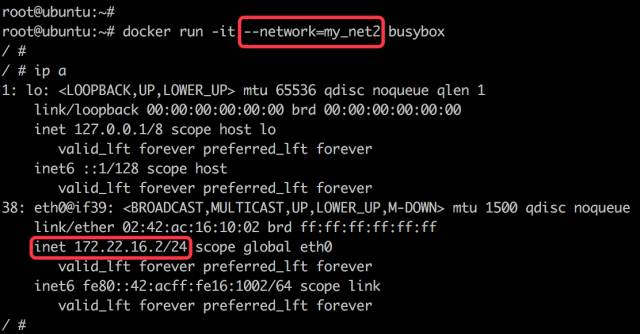

容器要使用新的网络,需要在启动时通过 --network 指定:

容器分配到的 IP 为 172.22.16.2。

到目前为止,容器的 IP 都是 docker 自动从 subnet 中分配,我们能否指定一个静态 IP 呢?

答案是:可以,通过--ip指定。

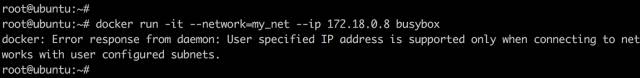

注:只有使用 --subnet 创建的网络才能指定静态 IP。

my_net 创建时没有指定 --subnet,如果指定静态 IP 报错如下:

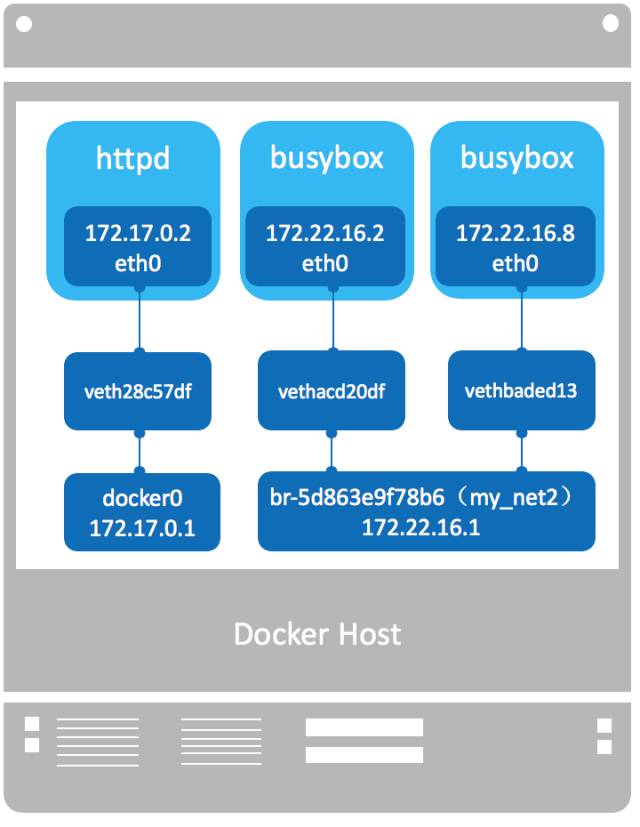

好了,我们来看看当前 docker host 的网络拓扑结构。

下一节讨论这几个容器之间的连通性。

相关文章

- 不背锅运维:解读docker容器网络

- Docker容器实战十:容器网络

- Docker容器网络(七)

- docker离线安装部署 linux_docker 离线安装

- 使用 Docker 和 Traefik 搭建轻量美观的计划任务工具

- Docker - docker-compose方式搭建高效的开发环境

- 关于Docker中 容器镜像管理,数据卷网络,本地仓库,容器监控的一些笔记

- docker 启动失败:Failed to start Docker Application Container Engine

- 【Docker】使用docker安装部署NextCloud私人网盘

- 【已解决】Cannot connect to the Docker daemon at unix:///var/run/docker.sock. Is the docker daemon runnin

- Docker服务的删除本地镜像命令(docker rmi 镜像id)

- Docker网络上篇-网络介绍

- Docker高级篇:docker网络的四种类型

- Docker网络模式

- 如何清理Docker容器、镜像、数据卷和网络

- Docker网络基础知识

- docker bridge网络实现原理

- 在Ubuntu Trusty 14.04 (LTS) (64-bit)安装Docker

- 7 步精简 Docker 镜像几百MB