Pytorch手势识别

2023-03-14 22:51:16 时间

一. 数据集介绍

1.数据集可以在kaggle上面下载地址.

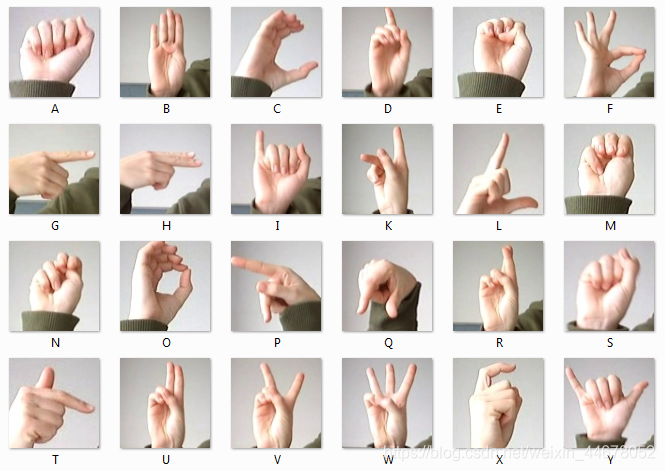

2.识别的手势是26个英文字母,如下所示,图片中好像缺少了一个Z。

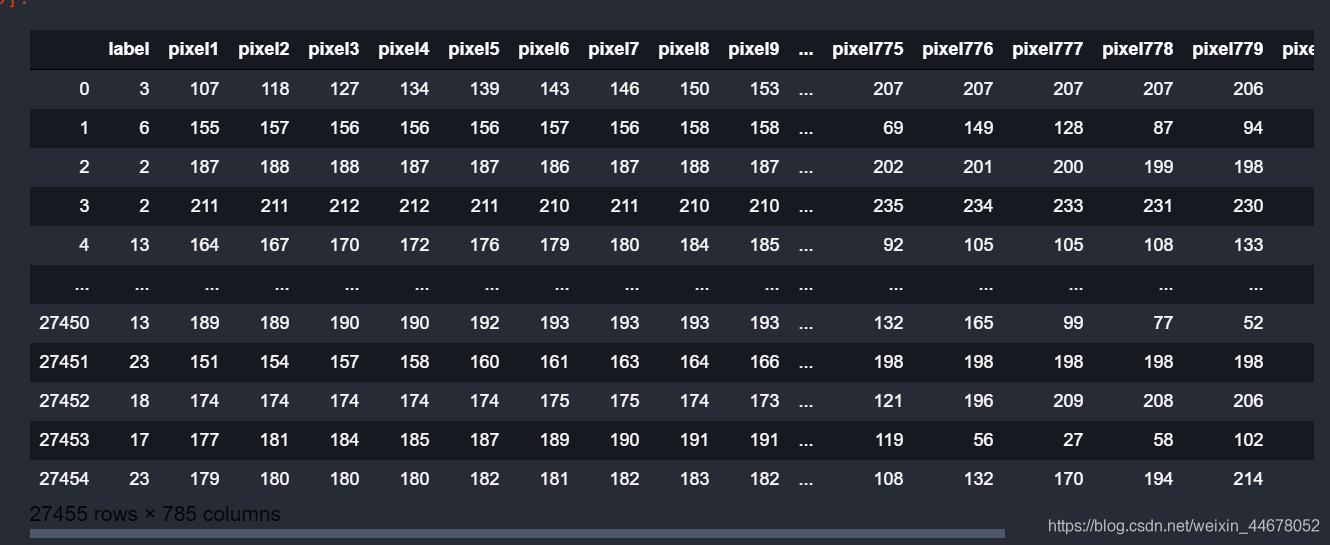

3.数据是csv格式的,第一列是label,其余的像素,也就是我们的图片数据,28*28大小的。

二. 构造DataLoader

1.由于数据是csv格式,和之前图片的有所不同,之前直接重写Dataset类就可以加载我们的数据,这次其实可以重写Dataset类,但是我这样做的时候,训练的时候准确率一直只有0.07左右,这次我们需要使用另外一种比较简单的方法,来构造数据集

2.利用TensorDataset函数将tensor数据变成TensorDataset数据,也就是将数据变成pytorch可以分批次加载的数据。

train = pd.read_csv('../input/sign-language-mnist/sign_mnist_train.csv',dtype=np.float32) #读取csv y = train.label.values #label x = train.loc[:,train.columns!= 'label'].values / 255 #图片数据 train_x,test_x,train_y,test_y = train_test_split(x,y,test_size=0.2,random_state=42) #分成数据集,测试集 print(test_x.shape) train_x = torch.from_numpy(train_x) #转换成tensor train_y = torch.from_numpy(train_y).type(torch.LongTensor) #转换成Longtensor,交叉熵损失函数的label需要long类型的数据 test_x = torch.from_numpy(test_x) test_y = torch.from_numpy(test_y).type(torch.LongTensor) train = TensorDataset(train_x,train_y) #转换成Dataset,类似于TensorFlow的from_tensor_slices test = TensorDataset(test_x,test_y) train_loader = DataLoader(train,batch_size=100,shuffle=False,drop_last=True) # 构造DataLoader test_loader = DataLoader(test,batch_size=100,shuffle=False,drop_last=True)

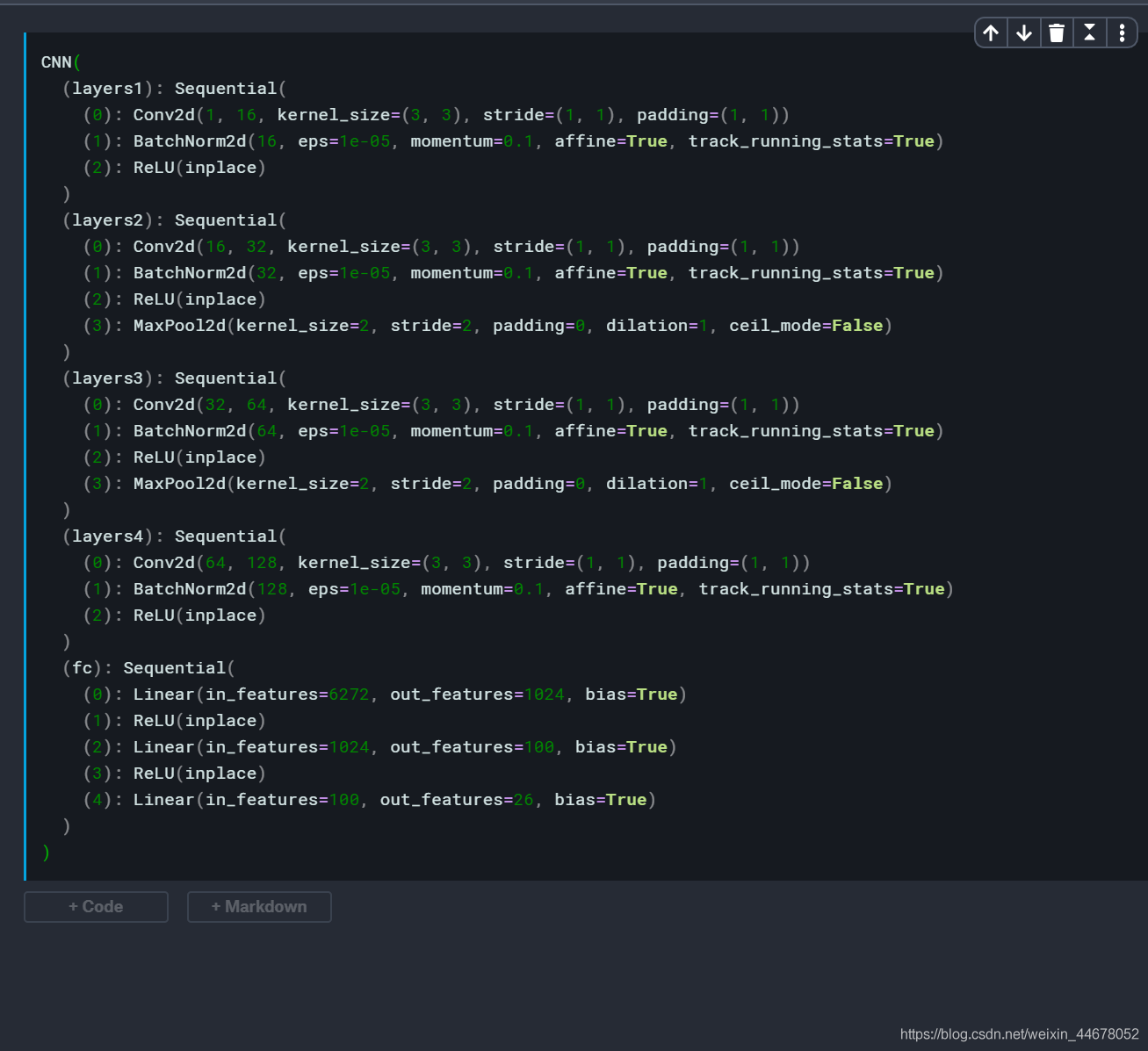

三. 构造网络

构造网络这比较简单,由于没有合适的GPU,只能使用一些比较简单的网络。

这里也可以使用残差网络,随便学一下什么是残差网络,残差网络在很深的网络中经常用到,非常重要的一个网络结构。

class CNN(nn.Module): def __init__(self): super(CNN, self).__init__() self.layers1 = nn.Sequential( nn.Conv2d(1,16,kernel_size=3,stride=1,padding=1), nn.BatchNorm2d(16), nn.ReLU(inplace=True) ) self.layers2 = nn.Sequential( nn.Conv2d(16,32,kernel_size=3,stride=1,padding=1), nn.BatchNorm2d(32), nn.ReLU(inplace=True), nn.MaxPool2d(kernel_size=2,stride=2) ) self.layers3 = nn.Sequential( nn.Conv2d(32,64,kernel_size=3,stride=1,padding=1), nn.BatchNorm2d(64), nn.ReLU(inplace=True), nn.MaxPool2d(kernel_size=2, stride=2) ) self.layers4 = nn.Sequential( nn.Conv2d(64,128,kernel_size=3,stride=1,padding=1), nn.BatchNorm2d(128), nn.ReLU(inplace=True), ) self.fc = nn.Sequential( nn.Linear(7*7*128,1024), nn.ReLU(inplace=True), nn.Linear(1024,100), nn.ReLU(inplace=True), nn.Linear(100,26) ) def forward(self, x): x = self.layers1(x) x = self.layers2(x) x = self.layers3(x) x = self.layers4(x) x = x.view(x.size(0),-1) x = self.fc(x) return x

四. 训练网络

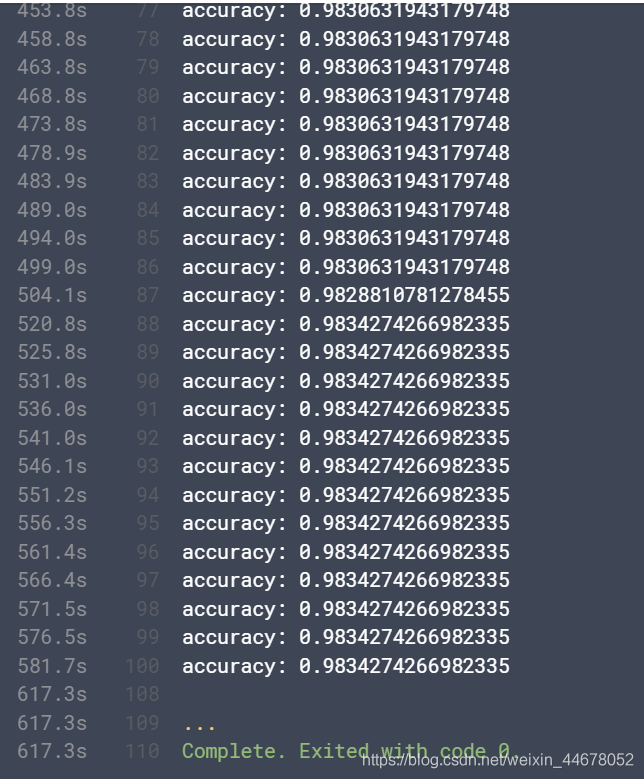

1.在训练网络的时候,这次我们分成了训练集合测试集,和之前写有些不一样,但也都差不多,

2.每训练50个epoch,就在测试集上测试一下准确率,这样可以明确模型的好与坏,精度如何。

3.最后如果准确率大于0.983后,就退出训练,训练太久而准确率没有太多的提升,还不如提前结束训练。

error = nn.CrossEntropyLoss() optimizer = torch.optim.SGD(cnn.parameters(),lr=0.1) for epochs in range(100): for i ,(img,label) in enumerate(train_loader): img = img.view(100,1,28,28) img = Variable(img) label = Variable(label) optimizer.zero_grad() output = cnn(img) loss = error(output,label) loss.backward() optimizer.step() if i %50 == 0: #测试模型 accuracy = 0 for x,y in test_loader: x = x.view(100,1,28,28) x = Variable(x) out = cnn(x) pre = torch.max(out.data,1)[1] accuracy += (pre == y).sum() print('accuracy:',accuracy.item()/(5491)) if(accuracy.item()/(5491)>0.975): torch.save(cnn.state_dict(),'model.pth') if(accuracy.item()/5491 > 0.983): break

最后打印一下训练的log,训练到最后准确率基本上没有变化了。

完整代码可在GitHub上面下载地址.

Thank for your reading !!!

公众号:FPGA之旅

相关文章

- 图像处理工具Python扩展库,你了解吗?

- 十个常用的损失函数解释以及Python代码实现

- 30 个数据科学工作中必备的 Python 包

- 如何在 Windows 上安装 Python

- 几行 Python 代码就可以提取数百个时间序列特征

- 使用Python快速搭建接口自动化测试脚本实战总结

- 哪种编程语言最适合开发网页抓取工具?

- 不要在 Python 中使用循环,这些方法其实更棒!

- 震惊!用Python探索《红楼梦》的人物关系!

- 如何最简单、通俗地理解Python模块?

- 酷炫,Python实现交通数据可视化!

- 为什么急于寻找Python的替代者?

- 30 个数据工程必备的Python 包

- 去字节面试被面这题能答上来吗?谈谈你对时间轮的理解?

- 火山引擎在行为分析场景下的 ClickHouse JOIN 优化

- 用Python爬取了某宝1166家月饼数据进行可视化分析,终于找到最好吃的月饼~

- 在 Linux 上试试这个基于 Python 的文件管理器

- Python列表解析式到底该怎么用?

- 如何快速把你的 Python 代码变为 API

- 十个Python初学者常犯的错误