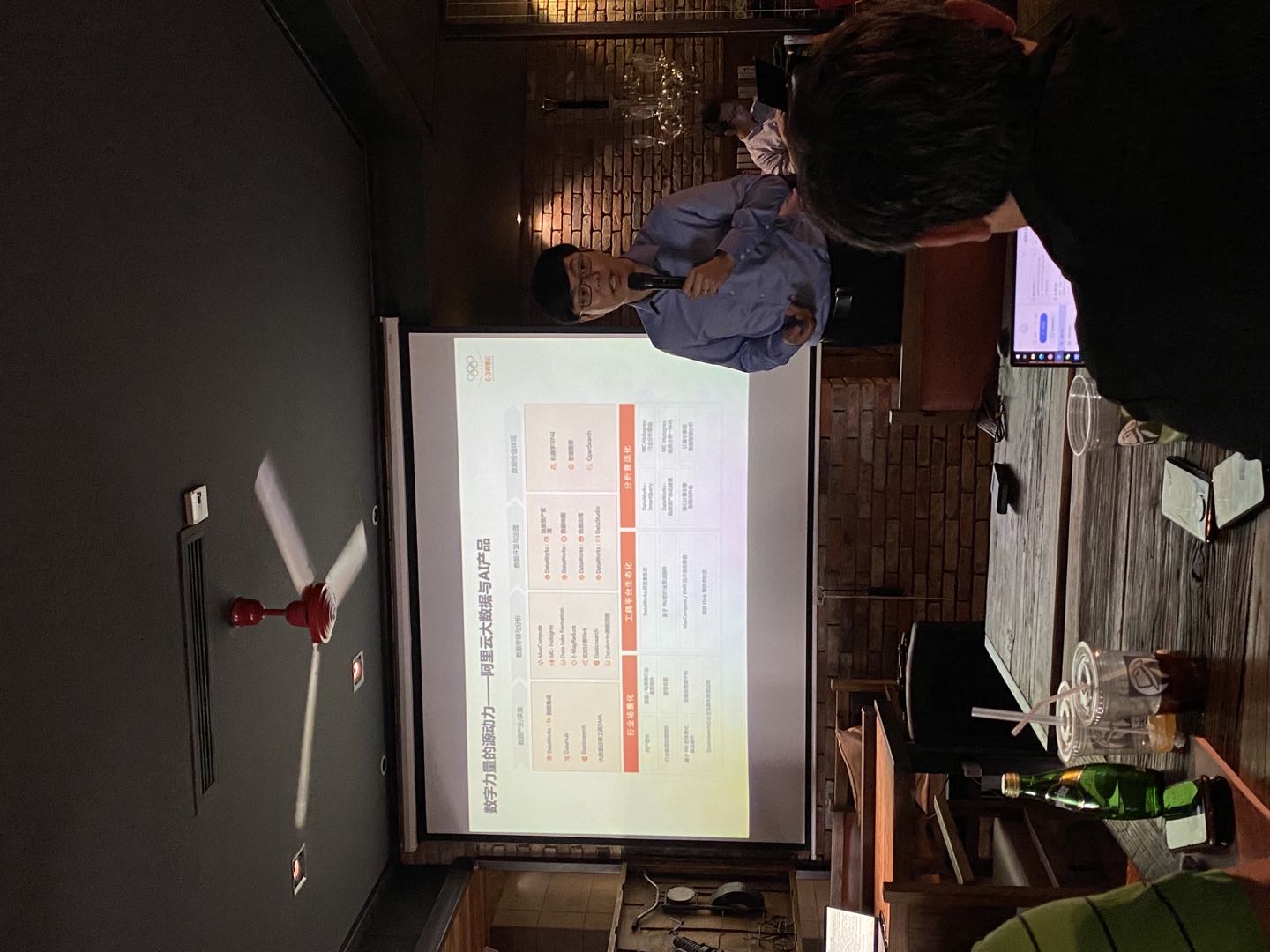

阿里贾扬清:通过大数据和 AI 能力,为企业提供升级的动力

【51CTO.com原创稿件】对企业来说,业务要创新、要提高效率,仅仅把数据管好、用好还不够,还需要AI技术的加持。“大数据和AI密不可分,二者结合在一起,才能帮助企业在数字时代从容应对不确定性。” 阿里巴巴副总裁、阿里云计算平台负责人贾扬清表示。

然而很多企业在进入AI领域时会发现,算法等技术已经不再是关键痛点,AI工程化落地场景、快速搭建AI工程化技术方案才是难以逾越的鸿沟。

什么是AI工程化,如何实施AI工程化,阿里云如何支持用户的AI工程化,贾扬清对此进行了深入介绍。

从供给角度看,AI 工程化是数据和算力的云原生化

众所周知,AI靠数据和算力来驱动。无论是计算机视觉、自然语言处理,还是其他的 AI 系统,都与数据量密不可分。

然而根据摩尔定律,每 18 个月,CPU 单核的计算能力就会增长一倍。但 2008 年前后,摩尔定律就开始失效,算力的增速开始逐渐变缓。

同时,随着数据量的增多,模型变得越来越精准,无论是在数据还是计算,都需要一个更大规模、更大体量的底座,来支撑AI 的需求。

日前,阿里巴巴与清华大学合作发布的超大规模中文多模态预训练千亿参数模型M6,其数据集包含超过1.9 TB图像和292GB文本,参数规模达到1000亿,可以完成产品描述生成、视觉问答、问答、中国诗歌生成等跨模态任务。

从核心技术角度看,AI 工程化是调度和编程范式的规模化

构建大规模、大体量底座往往面临着成本问题。首先,训练大模型需要GPU来做大规模计算。如英伟达的 DGX2,售价为每台20 万美元。一个训练模型需要64台机器、512个GPU。如果搭建一个专门用来做大规模训练的集群,可能需要约一个亿的成本。

阿里云在训练M6模型的时候,利用了生产机器明显的“潮汐效应”:白天在线服务量高,机器用的多,晚上流量少,计算量低。把 AI 计算任务分成一小块一小块的任务,部署在资源空闲的机器上,通过这样的方式,基本上可以实现在训练M6模型的时候,不用买新的机器,而是在现有生产的集群上,利用这种潮汐能力,把计算量提出来。

第二是人的成本。AI 没有相对清晰的、以目标为导向的框架,也不能简单的实现复制。AI 程序要在机器、资源之间调度数据,要把一个算法放到参数服务器上,给各种机器发布指令。因此,AI 工程师需要写很多复杂的代码。

如何更好地做到资源调度和资源调配,以及如何让工程师更容易撰写分布式编程范式,特别是如何规模化,这是另外一个明显的需求。

阿里云设计了一个相对简单、干净的编程框架 Whale,让开发者能够更容易地从单机的编程范式跳到分布式的编程范式。比如,只需告诉 Whale,将模型分为 4 个 stage,Whale 就会自动把这些 stage 放到不同的机器上去做运算。

从需求或者出口的角度看,AI 工程化是开发和服务的标准化、普惠化

AI 有很多有趣的模型,为了使这些模型能够更加紧密地应用在实际场景中,还需要做很多工作。但并不是每个人都有时间来学习 AI 如何建模,如何训练和部署等。

所以,阿里云一直在思考如何让开发者更容易使用高大上的 AI 技术。

阿里云机器学习平台 PAI 团队,基于阿里云 IaaS 产品,在云上构建了一个完整的 AI 开发全生命周期的管理体系:从写模型,到训练模型,再到部署模型。

阿里云机器学习平台PAI依托于云端计算降低存储和计算的成本。同时为了能够让算法更快地演进,需要提供很多的工具,让算法工程师能够非常方便地利用到系统计算的能力以及数据的能力。其中,Studio 平台提供可视化建模,DLC 平台(Deep Learning Container)提供云原生一站式的深度学习训练,DSW 平台(Data Science Workshop)提供交互式建模, EAS 平台(Elastic Algorithm Service )提供更简易、省心的模型推理服务。

截至目前,通过大数据、AI 平台,阿里云已经服务了各行各业的客户,如宝钢、三一集团、四川农信、太平洋保险、小红书、VIPKID、斗鱼等。阿里云希望通过大数据和 AI 能力,为企业提供升级的动力。

【51CTO原创稿件,合作站点转载请注明原文作者和出处为51CTO.com】

相关文章

- 直接在代码里面对list集合进行分页

- .NET Framework 4.5新特性详解

- 大数据的简要介绍

- 大数据的由来

- 高斯混合模型的自然梯度变量推理

- timing-wheel 仿Kafka实现的时间轮算法

- 使用Navicat软件连接自建数据库(Linux系统)

- 那一天,我被Redis主从架构支配的恐惧

- Redis 深入了解键的过期时间

- C#使用委托调用实现用户端等待闪屏

- 基于流计算 Oceanus 和 Elasticsearch Service 构建百亿级实时监控系统

- GRAND | 转录调控网络预测数据库

- JFreeChart API中文文档

- 临床相关突变查询数据库

- TIGER | 人类胰岛基因变化查询数据库

- 视频边缘计算网关EasyNVR在视频整体监控解决方案中的应用分析

- Apache Arrow - 大数据在数据湖后的下一个风向标

- 常见的电商数据指标体系

- AKShare-艺人数据-艺人流量价值

- MySQL中多表联合查询与子查询的这些区别,你可能不知道!